Framgång i dagens digitala värld hänger på att man förstår användarnas beteende och optimerar användarupplevelsen. A/B-testning, även känt som split testing eller bucket testing, har blivit en nyckelspelare på denna arena. Sidbyggarplattformar som Landingi har förenklat processen för webbplatstestning, vilket gör det tillgängligt för företag att genomföra dessa insiktsfulla experiment.

Den här artikeln handlar om sex verkliga exempel på A/B-testning och fallstudier som visar på split-testernas transformerande kraft. Vi kommer att utforska hur till synes mindre ändringar kan leda till betydande förbättringar av konverteringsresultatet. Vi kommer också att belysa de oväntade resultat som kan uppstå från sådana experiment, vilket bevisar att de mest överraskande förändringarna ibland kan ge de mest effektiva resultaten. Vi kommer också att diskutera vanliga fallgropar i bucket testing, inklusive förhastade processer, bortse från statistisk signifikans och göra ändringar baserat på ofullständiga resultat.

Följ med oss när vi navigerar i A/B-testvärlden och upptäcker dess potential att optimera konverteringsgraden och förbättra användarupplevelsen.

Vad är A/B-testning?

A/B-testning är en metod som hjälper till att fatta datadrivna beslut genom att jämföra olika versioner av en webbsida eller app för att avgöra vilken som presterar bäst. Det handlar ofta om att testa flera sidvarianter (A/B/x-testning) för att optimera användarupplevelsen och konverteringsgraden.

I Adelina Karpenkovas artikel med titeln ”A/B Testing in Marketing: The Best Practices Revealed” framgår det att testning är en integrerad del av CRO-processen (conversion rate optimization). Definitionen av A/B-test innebär att man undersöker hur liknande målgrupper reagerar på två versioner av identiskt innehåll, där den enda skillnaden ligger i en enda variabel.

Enligt CXL:s artikel ”5 Things We Learned from Analyzing 28,304 Experiments” av Dennis van der Heijden är sådana experiment det vanligaste testet för de flesta optimerare, med A/B-tester som utgör 97,5% av alla experiment på deras plattform. Split-tester har blivit populära på grund av deras potential för repeterbar framgång, ökade intäkter och optimering av konverteringsfrekvensen.

Se därför testningen som en superkraft inom marknadsföring som optimerar kampanjerna för maximal effekt.

Var används A/B-testning?

A/B-testapplikationer spänner över olika sektorer och har visat sig vara en spelförändrare i branscher som t.ex:

- e-handel

- SaaS

- publicering

- mobila appar

- e-postmarknadsföring

- sociala medier

Genom att skapa en ny version av en befintlig sida och jämföra dess prestanda med originalet kan företag öka konverteringsgraden och optimera sin digitala närvaro baserat på användarnas faktiska beteende och preferenser. Detta kan vara särskilt användbart när man hanterar flera sidor på en webbplats.

Vilka är fördelarna med A/B-testning?

Fördelarna med A/B-testning gör att du kan eliminera gissningar, fatta beslut baserade på konkreta bevis, optimera din online-närvaro och i slutändan uppnå bättre resultat. Fördelarna med split-test kan grupperas i 10 kategorier, som är följande:

- Förbättrad användarupplevelse (UX): Genom att testa olika varianter av ditt innehåll, din design eller dina funktioner kan du identifiera vilken version som ger en bättre användarupplevelse, vilket leder till ökad användarnöjdhet.

- Datadrivna beslut: A/B-testning ger konkreta data om vad som fungerar bäst för din målgrupp, vilket eliminerar behovet av att förlita sig på magkänsla eller antaganden. Detta möjliggör mer välgrundade beslut.

- Ökad konverteringsgrad: Genom att identifiera vilken version av en webbsida eller funktion som leder till bäst konverteringsgrad kan du optimera dina webbplatser för att öka försäljningen, antalet registreringar eller andra önskade åtgärder.

- Minskad avvisningsfrekvens: Om användarna tycker att ditt innehåll eller din layout är mer engagerande eller lättare att navigera i är det mindre troligt att de lämnar webbplatsen snabbt, vilket minskar avvisningsfrekvensen. Du kan till exempel upptäcka att mobilanvändare föredrar en annan layout eller innehållspresentation, vilket leder till en minskning av avvisningsfrekvensen på mobila enheter.

- Kostnadseffektivt: Många exempel på A/B-testning visar hur man genom att genomföra sådana tester kan förhindra kostsamma misstag. Genom att testa förändringar innan de implementeras fullt ut kan företag undvika att investera i funktioner eller design som inte går hem hos deras målgrupp.

- Minska riskerna: Att lansera stora förändringar utan att testa dem kan vara riskabelt. Med A/B-testning kan du testa förändringar på en mindre målgrupp först, vilket minskar de potentiella negativa effekterna av en fullskalig lansering.

- Förbättrat engagemang för innehåll: Genom att testa olika rubriker, bilder eller innehållslayouter kan du identifiera vad som engagerar användarna under längre perioder.

- Bättre ROI: För företag som spenderar pengar på reklam eller marknadsföringskampanjer kan A/B-testning säkerställa att landningssidorna är optimerade för konvertering, vilket leder till en bättre avkastning på investeringen.

- Förstå publikens preferenser: Med tiden kan konsekvent A/B-testning ge insikter om målgruppens preferenser och beteenden, vilket möjliggör bättre riktat innehåll och marknadsföringsstrategier.

- Kontinuerlig förbättring: Split testing främjar en kultur av ständiga förbättringar där företag alltid letar efter sätt att optimera och förbättra sin närvaro på nätet.

CXL:s rapport ”State of Conversion Optimization 2020” visar att A/B-testning är den näst bästa strategin för konverteringsoptimering. Dessutom, som Smriti Chawla påpekar i VWO:s ”CRO Industry Insights from Our In-App Survey Results”, har statistiskt signifikanta tester visat sig öka konverteringsgraden med i genomsnitt 49%.

Med detta sagt är det uppenbart att tydliga hypoteser och väl genomförda bucket-tests kan frigöra den fulla potentialen hos din webbplats eller app och maximera din avkastning på investeringen.

Vilka är nackdelarna med A/B-testning?

Den främsta nackdelen med A/B-testning är att man kan stöta bort användarna om testerna genomförs för ofta eller utan ordentlig förberedelse. Otillräckliga tester kan leda till att användarna får inkonsekventa upplevelser, vilket kan orsaka missnöje.

Vanliga fallgropar vid multivariata tester är dessutom förhastade processer, att man bortser från statistisk signifikans och att man gör förändringar baserat på ofullständiga testresultat. Snabba processer kan leda till dåligt utformade försök, medan bortseende från statistisk signifikans kan leda till beslut som baseras på slumpen snarare än på den faktiska effekten. Dessutom kan förändringar baserade på ofullständiga resultat skapa förvirring och leda till missvisande data.

Du måste avsätta tillräckligt med tid för varje test, se till att urvalet är tillräckligt stort för statistisk signifikans och avstå från att göra ändringar tills resultaten är slutgiltiga och statistiskt signifikanta.

Vanliga element som testas i A/B-tester

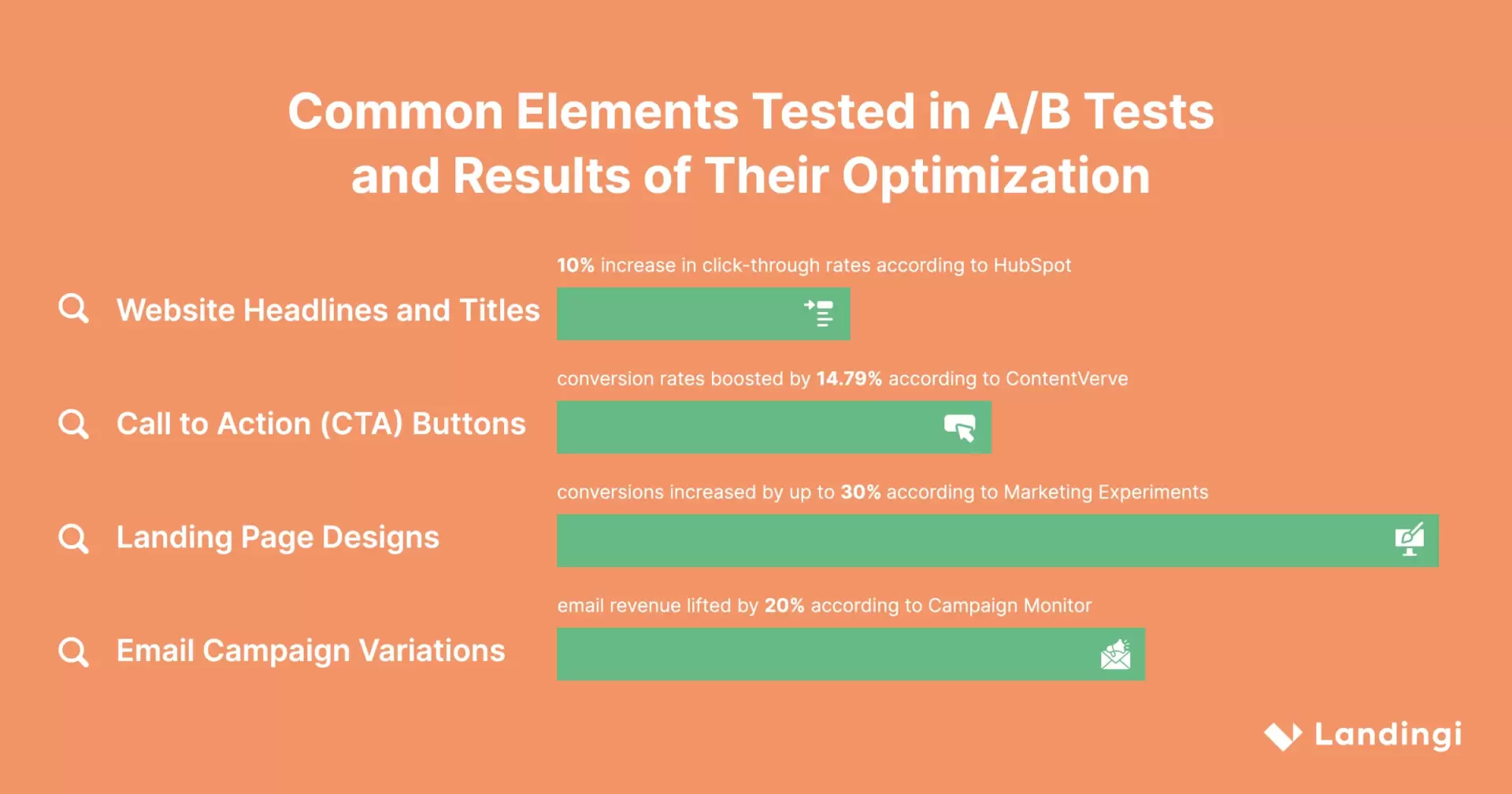

De vanligaste elementen som testas i A/B-tester är

- Rubriker och titlar

- CTA-knappar (uppmaning till handling)

- Design av landningssidor

- Variationer i e-postkampanjer

Det finns också många exempel på experiment med registreringsformulär, sociala bevis och annonstexter. Nyckeln till ett framgångsrikt multivariat test är att fokusera på de element som har störst inverkan på användarnas beteende och konverteringsfrekvens.

Låt oss utforska de mest populära elementen mer i detalj.

Rubriker och titlar på webbplatsen

En fängslande rubrik kan göra hela skillnaden när det gäller att attrahera och behålla webbplatsbesökare. Med A/B-testning kan du experimentera med olika rubriker och titlar för att identifiera vilka som går hem bäst hos din målgrupp. Genom att ändra faktorer som ordalydelse, budskap och stil kan du optimera din text för högre klickfrekvens, ökat engagemang och förbättrad prestanda på webbplatsen.

Enligt Hubspot kan experiment med rubriker och titlar öka klickfrekvensen med upp till 10%.

Knappar för uppmaning till handling (CTA)

CTA-knappar spelar en avgörande roll för att driva konverteringar. Med A/B-tester kan du jämföra olika versioner av CTA-knappar för att se vilken som ger bäst resultat när det gäller konverteringsgraden. Genom att ändra knapparnas design, färg, storlek, text eller position kan du påverka användarnas beteende och förbättra effekten av din uppmaning.

Split-testning av knappar har visat sig av ConvertVerve öka konverteringsfrekvensen med 14,79%.

Design av landningssidor

En väl utformad landningssida kan avsevärt förbättra användarupplevelsen och konverteringsgraden. I multivariata tester inkluderar vanligtvis modifierade funktioner:

- Sidans layout

- Rubriker

- Underrubriker

- Text i brödtext

- Prissättning

- Knappar

- Registrera dig flöde

- Formulärets längd

- Grafiska element

Att experimentera med olika varianter av landningssidor är avgörande för att optimera kvaliteten på leads och konverteringsgraden. Genom att testa olika designer kan du identifiera vilka element som resonerar med din publik och driver önskade åtgärder, och vilka som kan orsaka friktion eller förvirring. Denna process med kontinuerlig förbättring kan avsevärt förbättra den övergripande prestandan för en landningssida.

Marketing Experiments har visat att optimering av landningssidans design ökar konverteringen med upp till 30%.

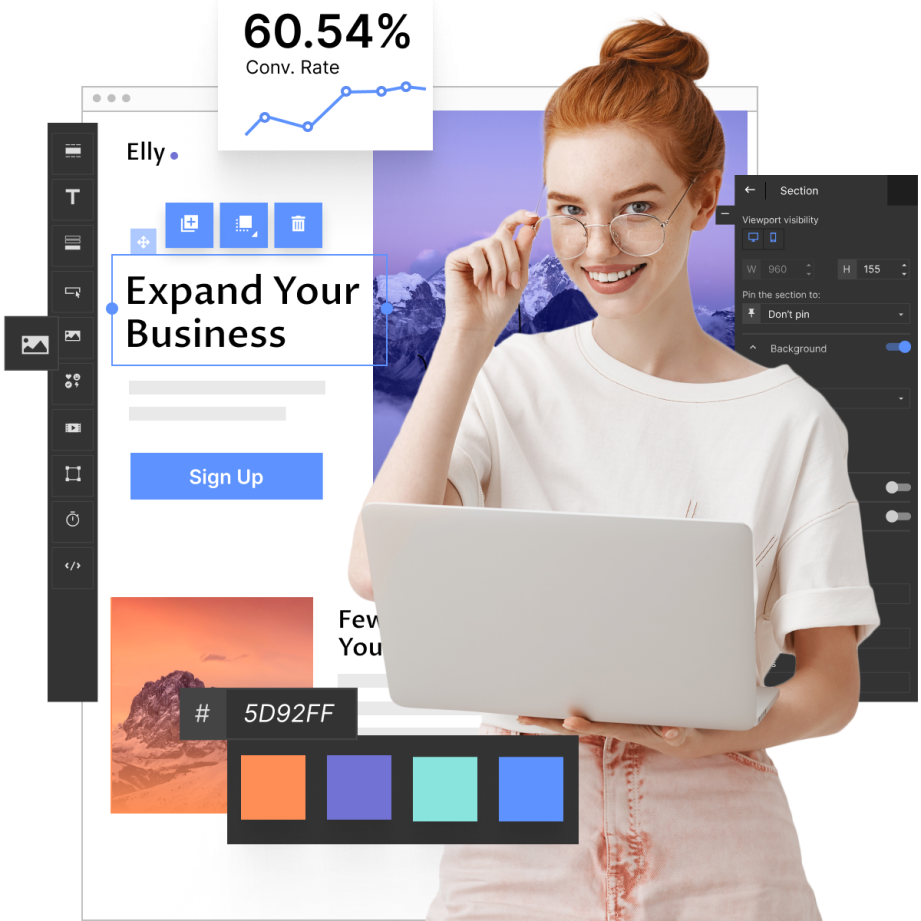

Landingi, en känd landningssidesbyggare, erbjuder en uppsjö av funktioner som tillgodoser just detta behov. Med sitt intuitiva gränssnitt och robusta testfunktioner gör Landingi det enkelt att skapa, duplicera, modifiera, testa och optimera landningssidor.

Make your sections smartable and let go of mundane manual tasks with Smart Sections! An easy way to manage bulk changes.

Variationer i e-postkampanjer

E-postkampanjer är ett kraftfullt marknadsföringsverktyg och A/B-testning kan hjälpa dig att optimera dina kampanjer så att de får maximal effekt. Genom att skapa och jämföra flera versioner av dina meddelanden kan du identifiera vilka varianter som går hem bättre hos din målgrupp och leder till högre öppningsfrekvenser och klickfrekvenser.

A/B-testning är ett ovärderligt verktyg som gör det möjligt för dig att förfina din e-postmarknadsföringsstrategi baserat på faktiska användarbeteenden och preferenser.

Tänk till exempel på ett företag som säljer handgjorda smycken online. De kan använda split testing för att hitta den mest effektiva ämnesraden för nyhetsbrev via e-post. De skapar två versioner av samma e-postmeddelande, som bara skiljer sig åt i ämnesraden. Ett e-postmeddelande kan ha ämnesraden ”Ny kollektion: Handgjorda smycken bara för dig” och det andra ”Upptäck ditt nya favoritsmycke”. Genom att skicka dessa e-postmeddelanden till olika delar av sin publik kan de spåra vilket e-postmeddelande som har en högre öppningsfrekvens. Den mest framgångsrika ämnesraden används sedan för framtida nyhetsbrev, vilket potentiellt kan leda till ökat engagemang och försäljning.

Enligt Campaign Monitor kan variationer i e-postkampanjer öka intäkterna från e-post med 20%.

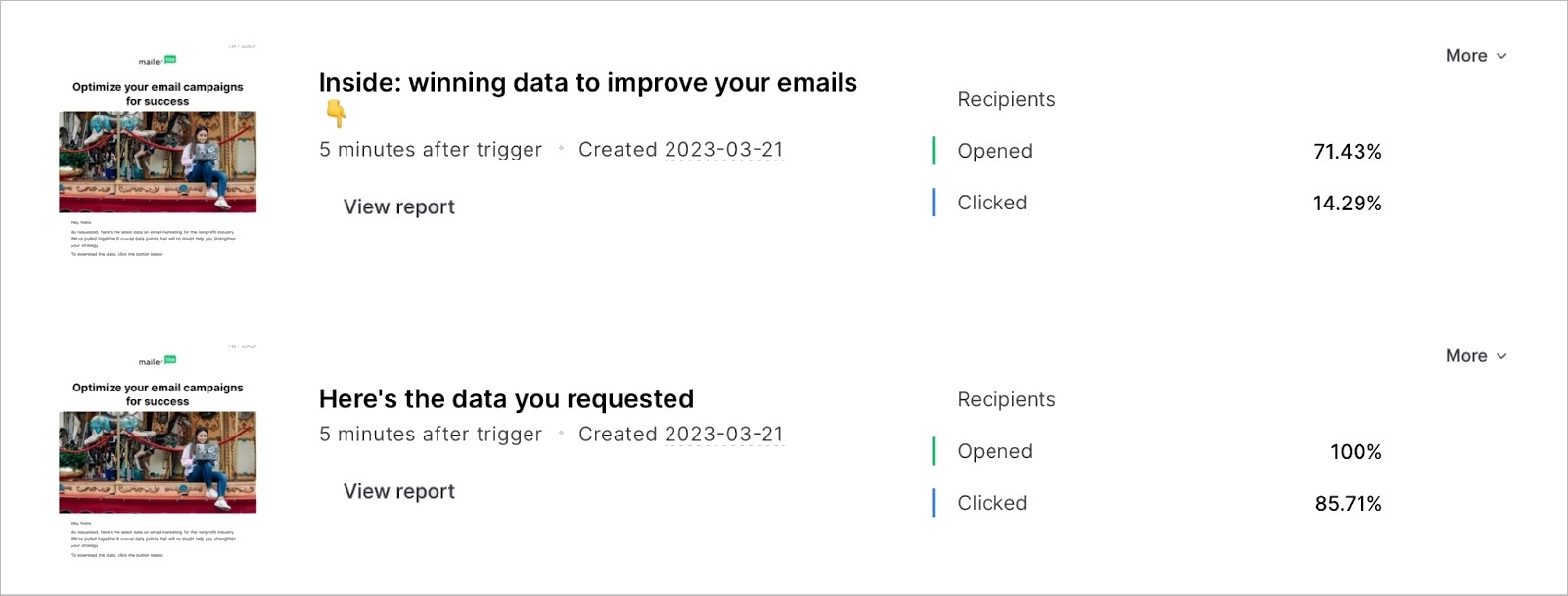

1. Exempel på A/B-testning av landningssida

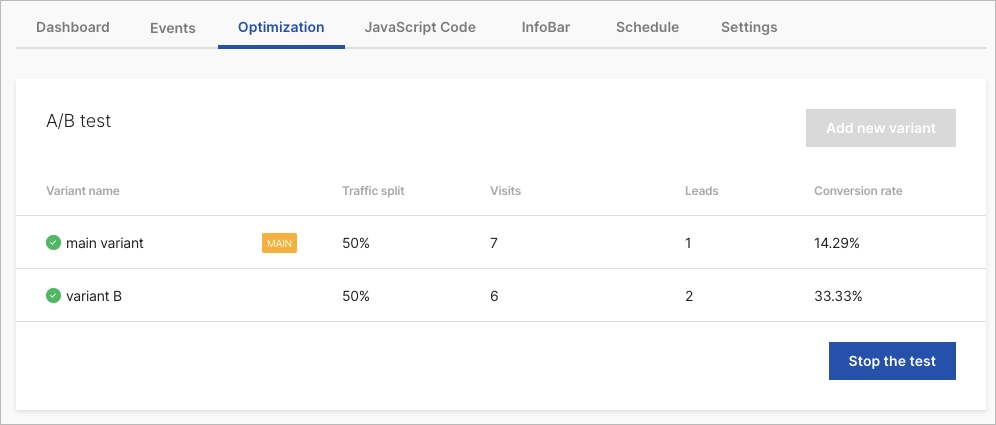

Det första av våra exempel på A/B-testning handlar naturligtvis om en landningssida, eftersom marknadsförare regelbundet testar den här typen av webbplatser. ForestView, en byrå baserad i Aten, Grekland, inledde en omfattande A/B-testkampanj för att optimera sin kunds landningssida.

Forestview-teamet antog att en minskning av mängden skrollning som krävs skulle hjälpa användarna att lättare hitta den produkt de föredrar, vilket skulle leda till förbättrade konverteringsgrader för formuläret. För att testa denna hypotes genomförde de ett A/B-test med en omdesignad landningssida. Den nya designen inkluderade filtrering på flera nivåer för att användarna skulle kunna hitta sin favoritprodukt dynamiskt och ersatte en lång lista med produkter med karuseller.

A/B-testet kördes i 14 dagar med över 5 000 besökare som delades lika mellan kontroll- och variationsgrupperna. Resultaten visade att variationen överträffade kontrollen, med flernivåfiltrering och karuselldesign som ökade konverteringsgraden för formuläret med 20,45% på mobil och 8,50% på desktop. Dessutom ökade användarengagemanget med 70,92%.

2. Exempel på SaaS A/B-testning

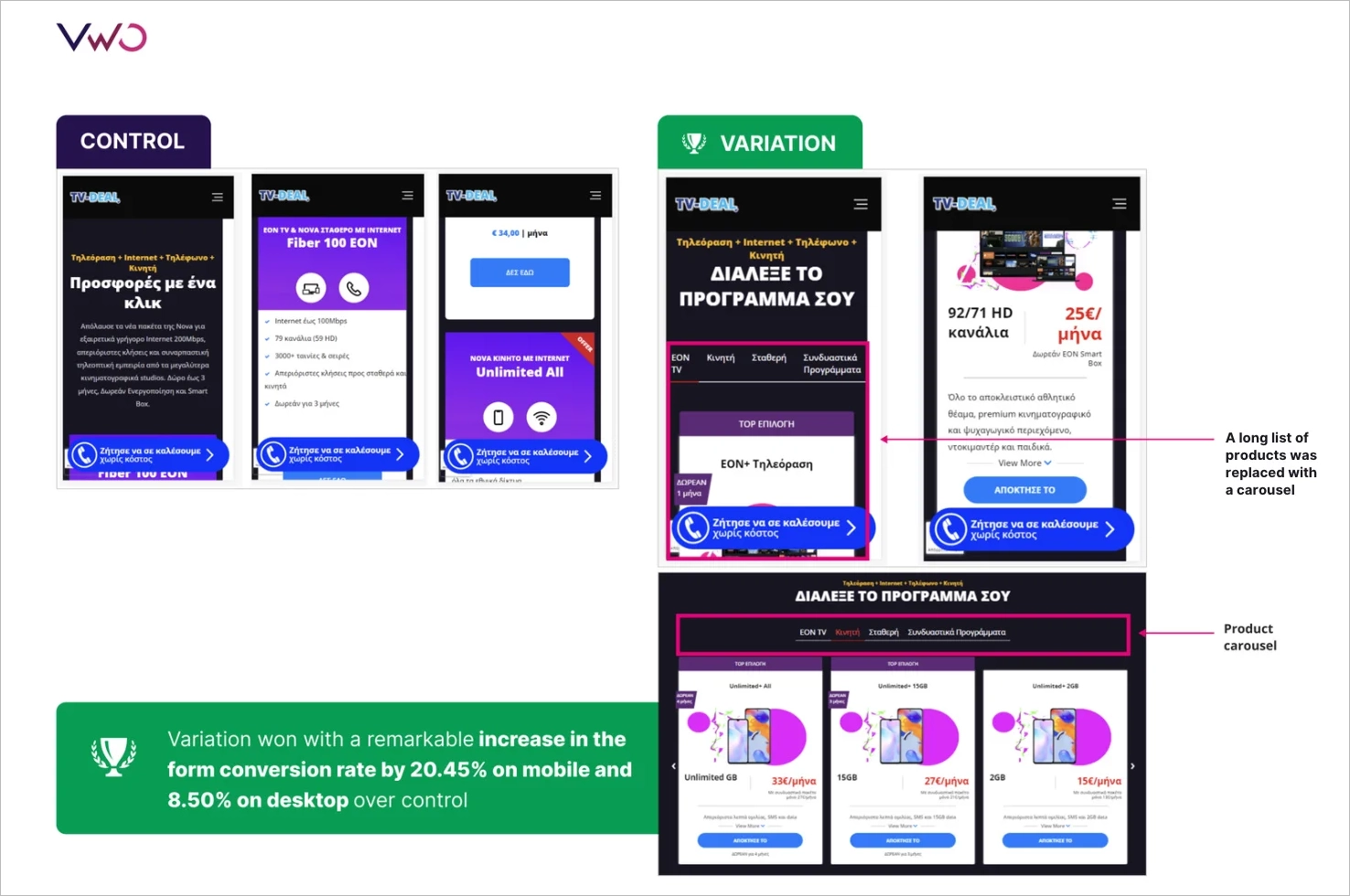

I SaaS-branschen sticker A/B-testning ut med sin transformativa kraft när det gäller att optimera webbplatsdesign. En artikel av Basecamps Signal v. Noise ger insikter i de konkreta fördelarna med split testing på Highrise marknadsföringswebbplats.

Teamet hade en hypotes om att en kortfattad design, kallad ”Person Page”, skulle tilltala användarna mer och resultera i högre konverteringsgrad. För att testa sin teori genomförde de ett A/B-test där de jämförde ”Person Page” med ”Long Form”-designen. Resultaten visade att ”Person Page” hade en 47-procentig ökning av betalda registreringar (102,5 % ökning jämfört med den ursprungliga designen). Men när de lade till extra information i designen sjönk dess effektivitet med 22%.

I ett annat experiment analyserade teamet hur kundbilder påverkade konverteringarna. De upptäckte att stora, glada kundbilder ökade konverteringarna, men att den specifika personen på bilden inte spelade någon roll.

Teamet tillbringade flera veckor med att genomföra A/B-tester och noggrant analysera användarnas beteende och preferenser. Den viktigaste lärdomen från experimenten var att bucket testing är ett värdefullt verktyg som kan avslöja antaganden och visa vilka designelement som verkligen uppskattas av användarna.

3. Exempel på A/B-testning av fastigheter

Fastighetsbranschen, liksom många andra, är starkt beroende av effektiviteten hos sina digitala plattformar. Fastighetsjättar som Zillow, Trulia och StreetEasy förstår vikten av att kontinuerligt förfina sin användarupplevelse för att tillgodose publikens behov. De uppnår detta genom att utföra A/B-testning, som beskrivs i Anadeas artikel ”Hur effektiv A/B-testning hjälper till att bygga en cool fastighetsapp”.

StreetEasy, en New York City-baserad fastighetsplattform, kände igen de unika preferenserna hos sin publik. De genomförde ett A/B-test för att bestämma de mest effektiva sökfiltren för sina användare och upptäckte att användarna föredrog att söka efter stadsdelar och byggnadstyper. I New York kan läget för en lägenhet och vilken typ av byggnad den ligger i avsevärt påverka en potentiell köpares eller hyresgästs beslut. Till exempel kanske någon som är van vid att bo i Tribeca inte är intresserad av en lägenhet i Chinatown, även om den uppfyller alla andra kriterier.

Förutom sökfilter är den visuella representationen av annonser också avgörande för potentiella köpare. Besökare spenderar ungefär 60% av sin tid på att titta på listningsfoton, vilket gör storleken på dessa bilder till en viktig faktor för användarengagemang och konverteringsfrekvenser.

Dessutom kan den beskrivning som följer med en annons påverka en potentiell köpares beslut. Zillow genomförde en studie där man analyserade 24 000 bostadsförsäljningar och upptäckte att vissa ord i annonsbeskrivningarna ledde till att bostäderna såldes till högre priser än förväntat. Ord som ”lyxig”, ”anlagd” och ”uppgraderad” visade sig öka konverteringsgraden.

Get 111 Landing Page Examples—The Ultimate Guide for FREE

4. Exempel på A/B-testning av mobilapp

Det fjärde av våra exempel på A/B-testning handlar om en mobilapp, med tanke på den ökande trenden med optimering av mobilappar. AppQuantum och Red Machine samarbetade kring en omfattande A/B-testkampanj för appen Doorman Story, som är ett tidshanteringssimuleringsspel där spelarna sköter sitt eget hotell. Exemplet beskrevs i artikeln ”How to Conduct A/B Tests in Mobile Apps: Part I” som publicerades på Mediums webbplats.

AppQuantum-teamet bestämde sig för att testa om införandet av en betald spelmekanik, specifikt en tuggummimaskin, kunde vara en lukrativ intäktsstrategi. Detta skulle innebära att sälja befintliga spelmekaniker som andra spel vanligtvis erbjuder gratis. De införde denna unika betalda spelmekanik i en specifik uppsättning nivåer och såg till att den inte störde den övergripande spelbalansen.

Syftet med A/B-testet var att mäta hur värdefull denna nya mekanik var för spelarna. De införde en betalvägg för att mäta användarnas reaktioner och för att avgöra om köpet ansågs värdefullt. Den främsta risken var dock att spelarna skulle bli avskräckta av att behöva betala för verktyg som tidigare varit gratis.

Efter att ha genomfört A/B-testet visade resultaten att den mest förenklade mekaniken var den mest framgångsrika. Detta oväntade resultat understryker vikten av A/B-testning i mobilappar och visar att de enklaste lösningarna ibland kan ge de bästa resultaten.

5. Exempel på A/B-testning av e-postmarknadsföring

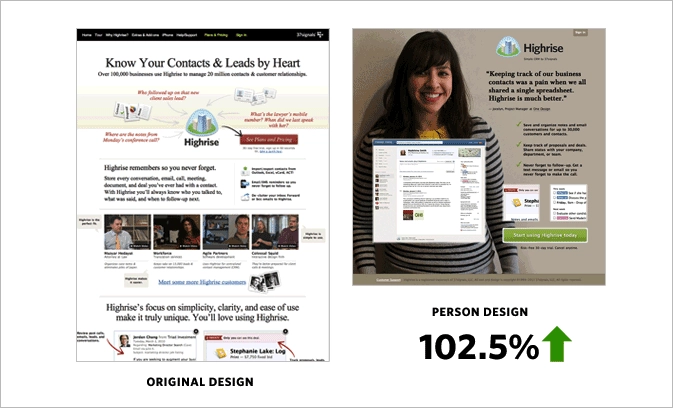

Spännande exempel på A/B-tester kommer från MailerLite och beskrivs i Jonas Fischers artikel ”A/B testing email marketing examples to improve campaigns, landing pages and more”. MailerLite-teamet genomförde flera A/B-tester genom åren för att fastställa effektiviteten av att använda emojis i ämnesrader i e-postmeddelanden, längden på ämnesrader, inleda ämnesraden med en fråga, positionering av bilder och GIF:ar samt testautomatisering.

Låt oss undersöka de två första alternativen för att få djupare insikter i A/B-testning av e-postmarknadsföring. Inledningsvis testade MailerLite-teamet emojis i sina ämnesrader, och resultaten var inte särskilt lovande. År 2020 var öppningsfrekvensen för en ämnesrad med emoji 31,82%, medan den utan emoji var 31,93%. Men allt eftersom tiden gick genomförde de fler A/B-splittester och fann konsekvent att emojis i ämnesraden var mer effektiva för deras målgrupp. Nya tester har visat att emojis i ämnesraden har en betydande positiv inverkan på öppningsfrekvensen. Öppningsfrekvensen för ett ämne med emoji var 37,33%, jämfört med 36,87% utan emoji.

Att testa ämnesradens längd visade också att den kan påverka e-postengagemanget. MailerLite fann att kortfattade ämnesrader var mer effektiva när det gällde att driva klick för sina prenumeranter. Testet visade att kortare ämnesrader kan uppnå en öppningsfrekvens på 100 % och en klickfrekvens på 85,71 %.

6. Exempel på A/B-testning av e-handel

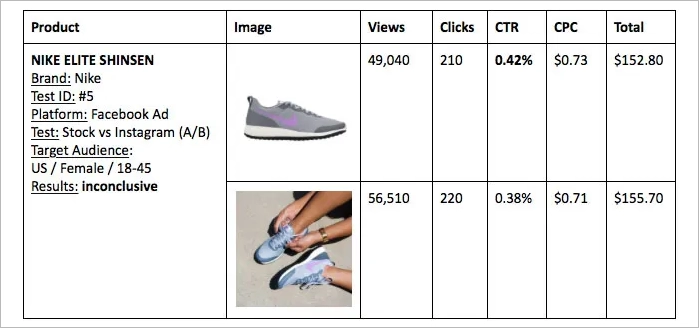

I artikeln ”The Battle of Conversion Rates – User Generated Content vs Stock Photos” av Tomer Dean undersöktes effektiviteten hos användargenererat innehåll (UGC) jämfört med stockfoton inom e-handeln. I en omfattande A/B-testkampanj, som främst handlade om mode och kläder, jämfördes bilder av riktiga människor som bar produkterna med professionellt tagna arkivbilder.

I ett av testerna ställdes en stockbild på en Nike sport-bh mot en användargenererad bild från Instagram. Resultaten var spännande, där UGC-bilden uppnådde en konverteringsgrad på 0,90 % jämfört med stockfotots 0,31 %. Liknande tester genomfördes för andra produkter, till exempel en kjol från Zara och löparskor från Nike, med varierande resultat. I ett annat experiment med röda högklackade skor var en landningssida som visade stockbilden tillsammans med tre UGC-bilder betydligt bättre än sidan med enbart stockbilden.

A/B-testerna underströk UGC:s potential när det gäller att förbättra konverteringsgraden. I artikeln betonas dock också vikten av kontinuerliga tester och att följa upphovsrättsliga normer när man köper bilder.

Vad som är ännu mer fascinerande är att e-handelssajter genererar en genomsnittlig intäkt på 3 USD per unik besökare, och ett framgångsrikt A/B-test ökar vanligtvis denna siffra med upp till 50%, vilket illustreras i Smriti Chawlas artikel ”CRO Industry Insights from Our In-App Survey Results” på VWO:s webbplats.

Kan A/B-testning tillämpas på varje element på en webbplats?

A/B-testning kan tillämpas på alla element på en webbplats, men det är viktigare att prioritera och fokusera på element som har en betydande inverkan på användarnas beteende och konverteringsgraden. Genom att systematiskt testa och optimera nyckelelement kan företag maximera fördelarna med A/B-testning och fatta datadrivna beslut som leder till förbättrad användarupplevelse och ökade intäkter.

Finns det en risk att man alienerar användarna med frekventa A/B-tester?

Om de inte planeras och utförs noggrant med tanke på användarupplevelse och preferenser kan frekventa A/B-tester potentiellt stöta bort användarna. Det är viktigt att hitta en balans mellan att testa och att upprätthålla en konsekvent användarupplevelse.

Vad är en kontrollgrupp i A/B-testning?

I A/B-testning avser en kontrollgrupp den ursprungliga versionen av en webbsida eller app, som fungerar som en baslinje för jämförelse med variationen. Kontrollgruppen fungerar som en referenspunkt för att bedöma effekterna av ändringar som gjorts i testversionen.

Vad innebär ett statistiskt signifikant resultat i A/B-tester?

Statistiskt signifikanta resultat i A/B-tester indikerar en hög grad av säkerhet för att den observerade skillnaden mellan kontrollen och variationen inte beror på slumpen. Nivån för statistisk signifikans är vanligtvis 95%, vilket innebär att det bara är 5% chans att den observerade skillnaden beror på slumpen.

Hur stor andel av A/B/x-testerna misslyckas?

Enligt CRO Industry Insights av Smriti Chawla från VWO är cirka 14% av A/B-testerna statistiskt signifikanta vinnande tester, vilket innebär att 86% inte lyckas förbättra konverteringsgraden. Convert.com:s forskning gav liknande resultat när det gäller påverkan på konverteringen. Misslyckandefrekvensen kan dock variera beroende på bransch och testets komplexitet.

Vilka är de populäraste verktygen som används vid A/B-testning?

Det finns flera populära A/B-testverktyg tillgängliga för att hjälpa företag att optimera sin digitala närvaro, t.ex:

- Optimistiskt

- VWO

- Google-optimera

- Adobe Mål

- AB Tasty

Dessa verktyg erbjuder olika funktioner som gör det möjligt för företag att utforma, hantera och analysera A/B-tester på ett effektivt sätt.

Vad har störst inverkan på användarnas beteende: att ändra CTA-färg eller text?

CTA-texten är ofta mer kritisk eftersom den direkt kommunicerar den önskade åtgärden. Både färg och text kan dock påverka användarnas beteende. Enligt en studie, ”The Button Color A/B Test: Red Beats Green” utförd av Joshua Porter på Hubspot, kan en ändring av färgen på en uppmaningsknapp resultera i en 21% ökning av konverteringar. Å andra sidan tyder Melanie Deziels forskning ”How to Build and Optimize CTA Buttons That Convert” på att personlig Call To Action-text kan förbättra konverteringsgraden med upp till 202%. Med detta sagt, även om en ändring av färgpaletten kan göra CTA-knappen mer visuellt tilltalande, kan en ändring av texten påverka användarnas beteende avsevärt och leda till högre konverteringar.

Vilka branscher har störst nytta av A/B-testning?

De branscher som har störst nytta av A/B-testning är bland annat

- E-handel

- SaaS

- Digital marknadsföring

- Utveckling av mobila appar

Företag i dessa branscher kan avsevärt förbättra sin digitala närvaro och uppnå tillväxt genom att implementera split-test för att optimera användarupplevelsen, förbättra konverteringsgraden och möjliggöra datadrivna beslut.

Vad är A/B-testning i marknadsföringsexemplet?

A/B-testning inom marknadsföring innebär att man jämför olika marknadsföringsstrategier, annonsmaterial eller meddelanden för att avgöra vilken som ger bäst resultat. Genom att systematiskt testa olika varianter av marknadsföringskampanjer kan företag identifiera vilka tillvägagångssätt som går hem hos målgruppen och leder till högre engagemang och konverteringar. Genom att köra fler tester får man dessutom en mer omfattande förståelse för vad som fungerar och vad som inte fungerar, vilket möjliggör mer exakta och effektiva marknadsföringsbeslut.

Vad är ett exempel på A/B-testning i sociala medier?

A/B-testning på sociala medier består av att jämföra olika annonsmaterial, inriktningsalternativ eller inläggsformat. Ett företag kan till exempel testa två olika bilder för en Facebook-annons, tillsammans med olika inriktningsalternativ, för att identifiera vilken kombination som resulterar i högre engagemang och konverteringar.

Varför använder vi A/B-test?

A/B-testning används för att underlätta datadrivna beslut, optimera användarupplevelsen och förbättra konverteringsgraden. Genom att systematiskt testa olika varianter av webbsidor, appar och marknadsföringskampanjer kan marknadsförare finjustera sina kampanjer, maximera avkastningen på investeringen och se till att de ligger steget före konkurrenterna och uppnår tillväxt.

Är A/B-testning en KPI?

A/B-testning kan betraktas som ett nyckeltal eftersom det hjälper till att mäta effektiviteten av ändringar som görs på en webbplats eller i en app och deras inverkan på användarnas beteende och konverteringar. Genom att systematiskt testa olika variationer och analysera resultaten kan företag identifiera de mest effektiva strategierna och elementen som driver konverteringar.

Vad är ett exempel på A/B-testning i verkliga livet?

Exempel på A/B-testning i verkliga livet är att testa olika prisstrategier, produktförpackningar eller butikslayouter för att optimera försäljningen och kundnöjdheten. Genom att jämföra olika versioner av dessa variabler kan företag identifiera vilka förändringar som leder till högre försäljning och en bättre kundupplevelse.

Vad är A/B-prover?

A/B-prover avser de två versioner (kontroll och variation) av en webbsida eller app som testas. Genom att jämföra prestandan hos dessa prover kan du identifiera vilken version som presterar bättre och optimera din digitala närvaro.

Hur många företag använder A/B-testning?

Enligt en undersökning från CXL Institute 2020, ”State of Conversion Optimization”, använder cirka 44% av företagen programvara för A/B-testning. Undersökningen genomfördes bland 333 företag av olika storlek, från små nystartade företag till stora företag, inom en rad olika branscher.

Användningen av A/B-testning är vanligare bland företag med en stark närvaro på nätet, till exempel e-handels- och SaaS-företag. I Econsultancy Conversion Rate Optimization Report 2019 framgick det till exempel att 77% av de företag som har ett strukturerat tillvägagångssätt för att förbättra konverteringsgraden använder A/B-testning i någon utsträckning.

Hur använder Netflix A/B-testning?

Netflix använder A/B-testning för att förbättra användarupplevelsen genom att testa olika användargränssnitt, rekommendationsalgoritmer, miniatyrbilder för program och filmer med mera. Målet är att avgöra vilka variationer användarna föredrar och vilka som leder till mer engagemang och längre tittartider.

Har YouTube A/B-testning?

YouTube tillhandahåller inte A / B-testverktyg för skapare. YouTube genomför dock själv A/B-testning på sin plattform för att optimera användarupplevelsen och funktionerna. Om skapare vill genomföra A/B-testning på sitt innehåll måste de använda externa verktyg eller metoder.

Har Shopify A / B-test?

Shopify stöder A/B-testning, men det har inte en inbyggd funktion för det. Det finns dock flera tredjepartsappar tillgängliga i Shopify app store som gör det möjligt att köra tester.

Kan Mailchimp göra A / B-test?

Ja, Mailchimp erbjuder A / B-testfunktioner. Det gör det möjligt för användare att testa olika ämnesrader, innehåll och sändningstider för att optimera e-postkampanjer.

Kan Wix göra A/B-test?

Wix har ingen inbyggd A/B-testfunktion, men verktyg från tredje part som Google Optimize kan integreras för A/B-testning på Wix-webbplatser. Företag som använder Wix kan genomföra A/B-tester för att optimera sina webbplatser, förbättra användarupplevelsen och öka konverteringsgraden genom att utnyttja dessa verktyg.

Gör Google A/B-test?

Ja, Google genomför ofta split testing för att utvärdera ändringar och förbättringar av sina produkter, tjänster och algoritmer. Detta hjälper Google att se till att nya funktioner eller ändringar ger en positiv användarupplevelse och uppfyller de avsedda målen.

Hur gör man A/B-test med Google Ads?

Följ dessa fyra steg för att genomföra A/B-tester med Google Ads:

- Identifiera det element som du vill testa (annonstext, målsida, sökord etc.).

- Skapa två versioner av din annons, en med det ursprungliga elementet och en med det modifierade elementet.

- Kör båda annonserna samtidigt under en viss period.

- Analysera prestandadata för båda annonserna för att avgöra vilken version som ger bättre resultat.

Hur genomför man ett A/B-test i Excel?

Du kan genomföra ett A/B-test i Excel genom att organisera dina data i två grupper: A (kontroll) och B (test). Beräkna medelvärde och standardavvikelse för båda grupperna. Använd sedan Excels t-testfunktion för att jämföra medelvärdena för de två grupperna och avgöra om det finns en statistiskt signifikant skillnad.

Hur mycket data behövs för A/B-testet?

Faktorer som den önskade nivån av statistisk signifikans, den förväntade effektstorleken och trafiken till den testade sidan eller appen påverkar mängden data som behövs för ett A/B-test. En större urvalsstorlek rekommenderas i allmänhet för ett mer tillförlitligt test, och vissa branschspecialister föreslår en minsta urvalsstorlek på 100 konverteringar per variation.

Det specifika sammanhanget och målen för A/B-testet bör också beaktas när man fastställer den lämpliga mängden data som behövs.

Är A/B-testning dyrt?

Kostnaden för A/B-testning beror på vilka verktyg du använder, hur komplexa testerna är och om du utför dem internt eller på entreprenad. Vissa onlineverktyg erbjuder kostnadsfria bastjänster, medan andra kan ta ut en månadsavgift.

Slutsats

A/B-testning är inte bara ett verktyg utan ett tankesätt för kontinuerlig förbättring och anpassning. Det ger marknadsförare möjlighet att fatta välgrundade beslut, med stöd av data, för att förfina sina strategier och uppnå optimala resultat. Oavsett om det handlar om att justera en CTA-knapp, experimentera med landningssidors design eller testa olika varianter av e-postkampanjer är A/B-testning en ovärderlig tillgång i marknadsförarens verktygslåda. I takt med att vi går djupare in i den digitala tidsåldern blir split testing allt viktigare för att forma användarupplevelser och driva affärsframgångar.

Plattformar som Landingi har demokratiserat tillgången till detta kraftfulla verktyg, vilket gör det möjligt för företag i alla storlekar att genomföra insiktsfulla experiment. Med Landingi kan du skapa en bra kampanj och optimera den med multivariata tester, kampanjschemaläggare, dynamisk textersättning och personaliseringsalternativ för att uppnå bästa resultat. Det mest spännande är att du kan börja använda Landingi-plattformen gratis!