Il successo nel mondo digitale di oggi dipende dalla comprensione del comportamento degli utenti e dall’ottimizzazione della loro esperienza. L’A/B testing, noto anche come split testing o bucket testing, è emerso come un attore chiave in questa arena. Le piattaforme di page builder come Landingi hanno semplificato il processo di testing dei siti web, rendendo accessibile alle aziende la conduzione di questi esperimenti approfonditi.

Questo articolo approfondisce sei esempi di A/B testing e casi di studio reali che dimostrano il potere trasformativo degli split test. Esploreremo come modifiche apparentemente minime possano portare a miglioramenti significativi nelle prestazioni di conversione. Faremo anche luce sui risultati inaspettati che possono emergere da questi esperimenti, dimostrando che a volte le modifiche più sorprendenti possono produrre i risultati più efficaci. Discuteremo anche le insidie più comuni dei bucket test, tra cui processi affrettati, non considerare la significatività statistica e apportare modifiche sulla base di risultati inconcludenti.

Unisciti a noi per navigare nel mondo dell’A/B testing e scoprire il suo potenziale per ottimizzare i tassi di conversione e migliorare l’esperienza dell’utente.

Che cos’è il test A/B?

L’A/B testing è un metodo che aiuta a prendere decisioni basate sui dati confrontando diverse versioni di una pagina web o di un’applicazione per determinare quale abbia prestazioni migliori. Spesso si tratta di testare più varianti di pagina (test A/B/x) per ottimizzare l’esperienza dell’utente e i tassi di conversione.

Nell’articolo di Adelina Karpenkova intitolato “A/B Testing in Marketing: The Best Practices Revealed”, si afferma che i test sono una componente integrale del processo di ottimizzazione del tasso di conversione (CRO). La definizione di test A/B indica lo studio delle risposte di un pubblico simile a due versioni di contenuti identici, in cui l’unica differenza risiede in una singola variabile.

Secondo l’articolo di CXL “5 Things We Learned from Analyzing 28,304 Experiments” (5 cose che abbiamo imparato dall’analisi di 28,304 esperimenti) di Dennis van der Heijden, questa sperimentazione è il test preferito dalla maggior parte degli ottimizzatori, con i test A/B che rappresentano il 97,5% di tutti gli esperimenti sulla loro piattaforma. Gli split test hanno guadagnato popolarità grazie al loro potenziale di successo ripetibile, all’aumento dei ricavi e all’ottimizzazione del tasso di conversione.

Pertanto, pensate a questo test come a un superpotere del marketing che ottimizza le campagne per ottenere il massimo impatto.

Dove si utilizzano i test A/B?

L’applicazione dell’A/B testing si estende a vari settori, dimostrando di essere un fattore di svolta in settori quali:

- Commercio elettronico

- SaaS

- editoria

- applicazioni mobili

- marketing via e-mail

- social media

Creare una nuova versione di una pagina esistente e confrontarne le prestazioni con l’originale consente alle aziende di incrementare i tassi di conversione e di ottimizzare la propria presenza digitale in base al comportamento e alle preferenze effettive degli utenti. Questo può essere particolarmente utile quando si gestiscono più pagine di un sito web.

Quali sono i vantaggi dei test A/B?

I vantaggi dei test A/B consentono di eliminare le congetture, di prendere decisioni basate su prove concrete, di ottimizzare la presenza online e, in definitiva, di ottenere risultati migliori. I vantaggi degli split test possono essere raggruppati in 10 categorie, che sono le seguenti:

- Miglioramento dell’esperienza utente (UX): Testando diverse varianti dei contenuti, del design o delle funzionalità, è possibile individuare la versione che offre una migliore esperienza all’utente, con conseguente aumento della sua soddisfazione.

- Decisioni guidate dai dati: I test A/B forniscono dati concreti su ciò che funziona meglio per il vostro pubblico, eliminando la necessità di affidarsi a sensazioni o ipotesi. Ciò consente di prendere decisioni più informate.

- Aumento dei tassi di conversione: Identificando quale versione di una pagina web o di una funzione porta a tassi di conversione migliori, potete ottimizzare i vostri siti per ottenere più vendite, iscrizioni o qualsiasi altra azione desiderata.

- Riduzione della frequenza di rimbalzo: Se gli utenti trovano i vostri contenuti o il vostro layout più coinvolgenti o più facili da navigare, è meno probabile che abbandonino rapidamente il sito, riducendo la frequenza di rimbalzo. Ad esempio, potreste scoprire che gli utenti di dispositivi mobili preferiscono un layout o una presentazione dei contenuti diversi, con conseguente riduzione della frequenza di rimbalzo sui dispositivi mobili.

- Efficace dal punto di vista dei costi: Molti esempi di A/B testing dimostrano come la conduzione di tali prove possa evitare errori costosi. Testando le modifiche prima di implementarle completamente, le aziende possono evitare di investire in funzionalità o design che non hanno risonanza con il pubblico.

- Riduzione del rischio: Lanciare grandi cambiamenti senza testarli può essere rischioso. I test A/B consentono di testare prima le modifiche su un pubblico più ristretto, riducendo il potenziale impatto negativo di un lancio su larga scala.

- Miglioramento del coinvolgimento dei contenuti: Testare titoli, immagini o layout di contenuto diversi può aiutare a identificare ciò che mantiene gli utenti impegnati più a lungo.

- Migliore ROI: Per le aziende che spendono denaro in campagne pubblicitarie o di marketing, i test A/B possono garantire che le pagine di destinazione siano ottimizzate per la conversione, portando a un migliore ritorno sull’investimento.

- Comprendere le preferenze del pubblico: Nel corso del tempo, i test A/B costanti possono fornire informazioni sulle preferenze e sui comportamenti del pubblico, consentendo di elaborare contenuti e strategie di marketing più mirati.

- Miglioramento continuo: Lo split testing favorisce una cultura del miglioramento continuo, in cui le aziende sono sempre alla ricerca di modi per ottimizzare e migliorare la loro presenza online.

Il rapporto di CXL “State of Conversion Optimization 2020” indica che i test A/B sono al secondo posto tra le migliori strategie di ottimizzazione della conversione. Inoltre, come sottolinea Smriti Chawla in “CRO Industry Insights from Our In-App Survey Results” di VWO, è stato dimostrato che i test statisticamente significativi aumentano i tassi di conversione in media del 49%.

Detto questo, è evidente che ipotesi chiare e bucket test ben eseguiti possono sbloccare il pieno potenziale del vostro sito web o della vostra app e massimizzare il ritorno sugli investimenti.

Quali sono gli svantaggi dei test A/B?

Lo svantaggio principale dei test A/B risiede nella possibilità di allontanare gli utenti se i test vengono condotti troppo frequentemente o senza un’adeguata preparazione. Test inadeguati possono portare gli utenti a sperimentare esperienze incoerenti, con conseguente insoddisfazione.

Inoltre, le insidie comuni nei test multivariati includono processi affrettati, la mancata considerazione della significatività statistica e l’introduzione di modifiche basate su risultati non conclusivi. Processi affrettati possono portare a studi mal progettati, mentre il mancato rispetto della significatività statistica può portare a decisioni basate sul caso piuttosto che sull’effetto reale. Inoltre, apportare modifiche sulla base di risultati non conclusivi può creare confusione e portare a dati fuorvianti.

È necessario prevedere un tempo adeguato per ogni test, garantire una dimensione del campione sufficiente per la significatività statistica e astenersi dall’apportare modifiche fino a quando i risultati non saranno definitivi e statisticamente significativi.

Elementi comuni testati nei test A/B

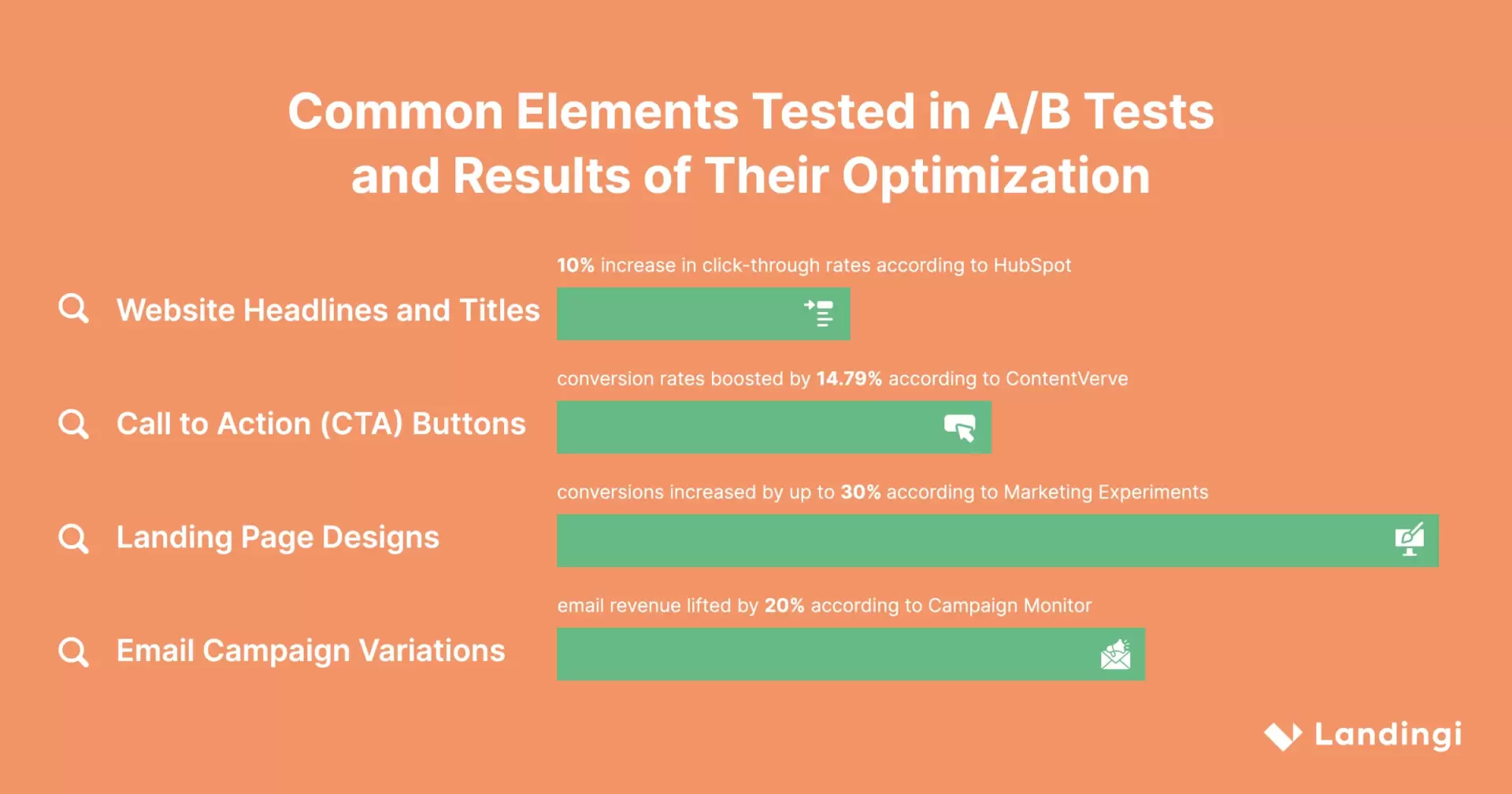

Gli elementi più comuni testati nei test A/B includono:

- Titoli e intestazioni

- Pulsanti CTA (Call To Action)

- Design di landing page

- Variazioni della campagna e-mail

Ci sono anche molti esempi di sperimentazione con i moduli di iscrizione, le sezioni di social proof e la copia degli annunci. La chiave per un test multivariato di successo è concentrarsi sugli elementi che hanno l’impatto più significativo sul comportamento degli utenti e sul tasso di conversione.

Analizziamo in dettaglio gli elementi più diffusi.

Titoli e intestazioni dei siti web

Un titolo accattivante può fare la differenza nell’attrarre e trattenere i visitatori di un sito web. I test A/B consentono di sperimentare diversi titoli e intestazioni per individuare quelli che risuonano meglio con il pubblico di riferimento. Modificando fattori quali la formulazione, il messaggio e lo stile, è possibile ottimizzare il testo per ottenere tassi di clic più elevati, maggiore coinvolgimento e migliori prestazioni del sito web.

Secondo Hubspot, sperimentare con titoli e intestazioni può aumentare la percentuale di clic fino al 10%.

Pulsanti di invito all’azione (CTA)

Ipulsanti CTA svolgono un ruolo cruciale nel guidare le conversioni. I test A/B consentono di confrontare diverse versioni dei pulsanti CTA per individuare quella che produce risultati migliori in termini di tassi di conversione. Modificando il design, il colore, le dimensioni, il testo o la posizione dei pulsanti, è possibile influenzare il comportamento degli utenti e migliorare l’efficacia della call to action.

Lo split testing dei pulsanti è stato dimostrato da ConvertVerve per aumentare i tassi di conversione del 14,79%.

Design di pagine di atterraggio

Una landing page ben progettata può migliorare significativamente l’esperienza dell’utente e i tassi di conversione. Nei test multivariati, le caratteristiche comunemente modificate includono:

- Layout della pagina

- Titoli di giornale

- Sottotitoli

- Testo del corpo

- Prezzi

- Pulsanti

- Flusso di iscrizione

- Lunghezza del modulo

- Elementi grafici

Sperimentare diverse varianti di landing page è fondamentale per ottimizzare la qualità dei lead e i tassi di conversione. Testando diversi design, è possibile identificare quali elementi risuonano con il pubblico e guidano le azioni desiderate, e quali invece possono causare attrito o confusione. Questo processo di miglioramento continuo può migliorare significativamente le prestazioni complessive di una landing page.

Esperimenti di marketing hanno dimostrato che l’ottimizzazione del design delle landing page aumenta le conversioni fino al 30%.

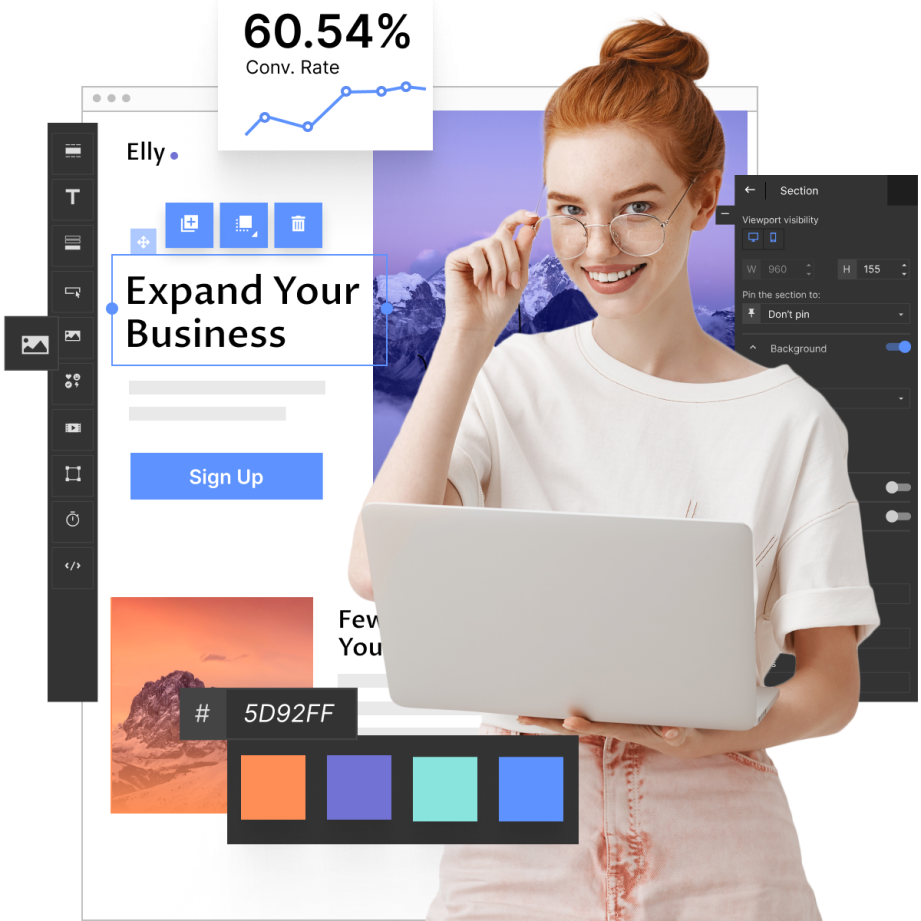

Landingi, un rinomato costruttore di pagine di destinazione, offre una pletora di funzioni che rispondono proprio a questa esigenza. Con la sua interfaccia intuitiva e le sue solide capacità di test, Landingi rende facile creare, duplicare, modificare, testare e ottimizzare le landing page.

Make your sections smartable and let go of mundane manual tasks with Smart Sections! An easy way to manage bulk changes.

Variazioni delle campagne e-mail

Le campagne e-mail sono un potente strumento di marketing e i test A/B possono aiutarvi a ottimizzare le vostre campagne per ottenere il massimo impatto. Creando e confrontando più versioni dei vostri messaggi, potete identificare quali variazioni hanno una migliore risonanza con il vostro pubblico di riferimento e portano a tassi di apertura e di clic più elevati.

I test A/B sono uno strumento prezioso che consente di perfezionare la strategia di email marketing in base al comportamento e alle preferenze effettive degli utenti.

Ad esempio, consideriamo un’azienda che vende gioielli fatti a mano online. Potrebbe utilizzare lo split testing per trovare l’oggetto più efficace per le newsletter via e-mail. Creano due versioni della stessa e-mail, che differiscono solo per l’oggetto. Una email potrebbe avere come oggetto “Nuova collezione: Gioielli fatti a mano solo per te” e l’altra “Scopri il tuo nuovo pezzo preferito”. Inviando queste e-mail a diversi sottoinsiemi del loro pubblico, possono verificare quale e-mail ha un tasso di apertura più elevato. L’oggetto di maggior successo viene poi utilizzato per le newsletter future, con un potenziale aumento del coinvolgimento e delle vendite.

Secondo Campaign Monitor, le variazioni delle campagne e-mail possono aumentare i ricavi delle e-mail del 20%.

1. Esempio di test A/B della pagina di destinazione

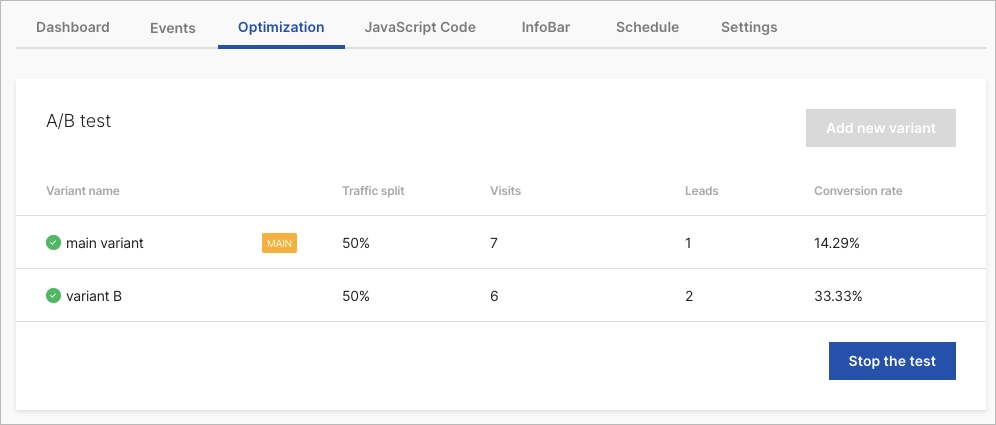

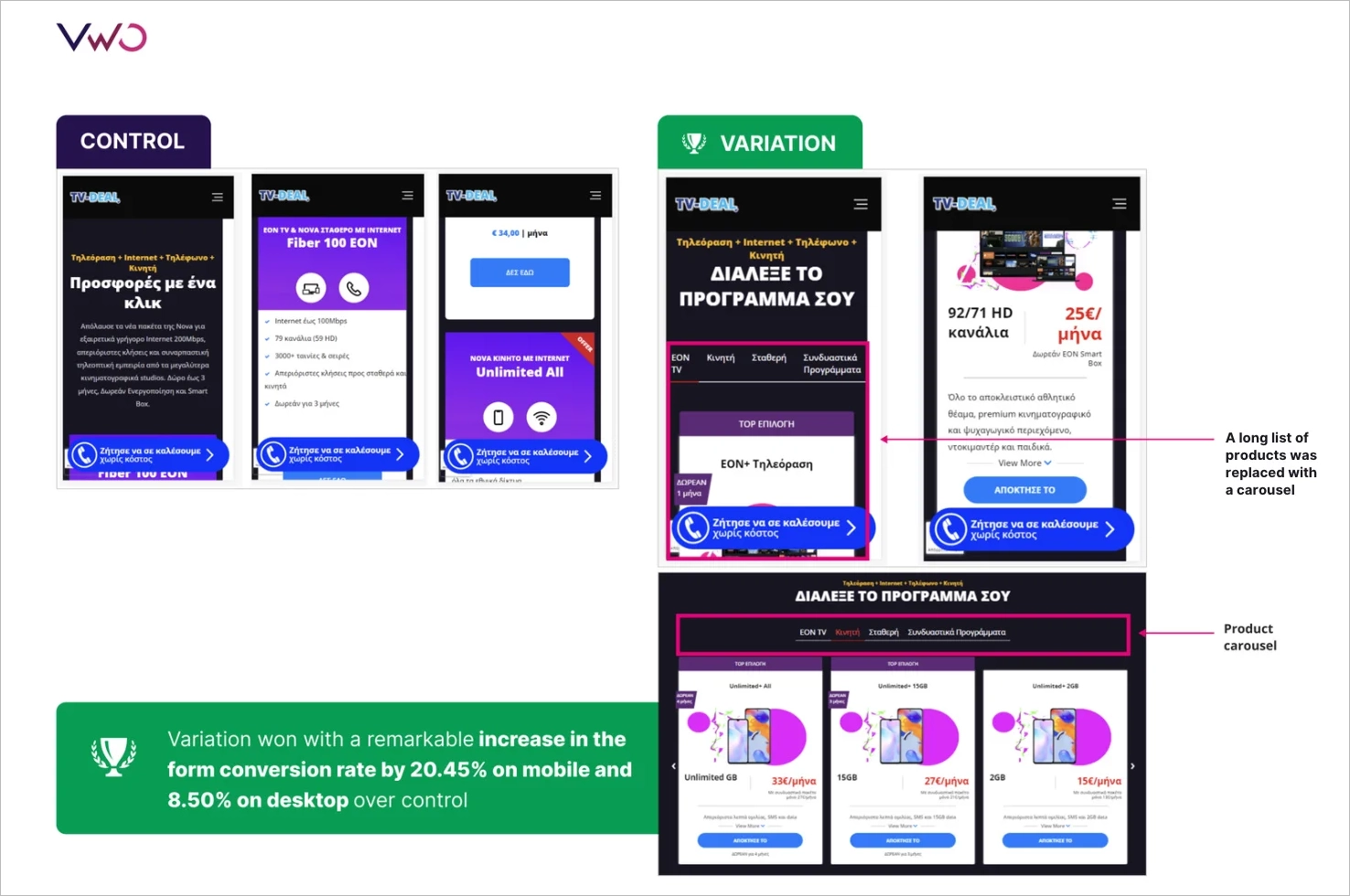

Il primo dei nostri esempi di A/B testing riguarda naturalmente una landing page, dato che i marketer testano regolarmente questo tipo di sito web. ForestView, un’agenzia con sede ad Atene, in Grecia, ha intrapreso una vasta campagna di A/B testing per ottimizzare la pagina di destinazione del proprio cliente.

Il team di Forestview ha ipotizzato che la riduzione della quantità di scorrimento necessaria avrebbe aiutato gli utenti a trovare più facilmente il prodotto preferito, con conseguente miglioramento dei tassi di conversione del modulo. Per verificare questa ipotesi, hanno condotto un test A/B con una landing page ridisegnata. Il nuovo design includeva un filtro multilivello per consentire agli utenti di trovare il prodotto preferito in modo dinamico e sostituiva un lungo elenco di prodotti con caroselli.

Il test A/B è stato condotto per 14 giorni, con oltre 5.000 visitatori suddivisi equamente tra il gruppo di controllo e quello di variazione. I risultati hanno dimostrato che la variante ha superato il gruppo di controllo, con il filtraggio multilivello e il design a carosello che hanno aumentato il tasso di conversione dei moduli del 20,45% su mobile e dell’8,50% su desktop. Inoltre, il coinvolgimento degli utenti è aumentato del 70,92%.

2. Esempio di test A/B SaaS

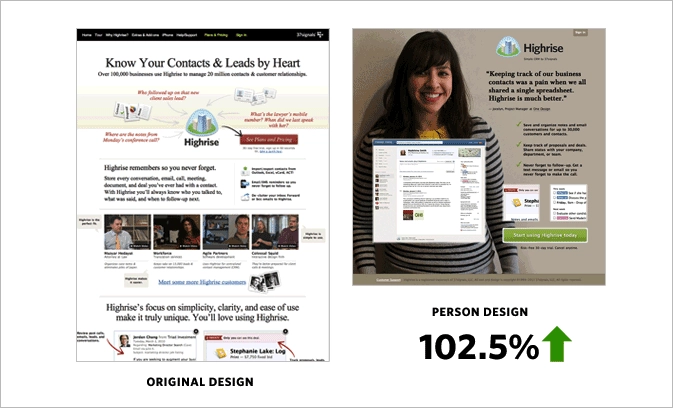

Nel settore SaaS, il test A/B si distingue per il suo potere di trasformazione nell’ottimizzazione del design dei siti web. Un articolo di Basecamp, Signal v. Noise, illustra i vantaggi concreti dello split testing sul sito di marketing di Highrise.

Il team ha ipotizzato che un design conciso, denominato “Person Page”, avrebbe attratto maggiormente gli utenti e avrebbe portato a tassi di conversione più elevati. Per verificare la loro teoria, hanno condotto un test A/B che ha messo a confronto la “Person Page” con il design “Long Form”. I risultati hanno mostrato che la “Pagina personale” ha registrato un aumento del 47% delle iscrizioni a pagamento (102,5% in più rispetto al design originale). Tuttavia, quando hanno aggiunto ulteriori informazioni al design, la sua efficacia è diminuita del 22%.

In un altro esperimento, il team ha analizzato l’impatto delle foto dei clienti sulle conversioni. Hanno scoperto che le immagini di clienti grandi e allegri aumentavano le conversioni, ma la persona specifica raffigurata nell’immagine non aveva importanza.

Il team ha trascorso diverse settimane a condurre test A/B, analizzando attentamente il comportamento e le preferenze degli utenti. Il risultato principale dei loro esperimenti è stato che il bucket testing è uno strumento prezioso che può sfatare le ipotesi e rivelare gli elementi di design che risuonano veramente con gli utenti.

3. Esempio di test A/B nel settore immobiliare

Il settore immobiliare, come molti altri, si basa molto sull’efficacia delle sue piattaforme digitali. Giganti del settore immobiliare come Zillow, Trulia e StreetEasy comprendono l’importanza di perfezionare continuamente la loro esperienza utente per soddisfare le esigenze del loro pubblico. Per ottenere questo risultato, effettuano test A/B, come descritto nell’articolo di Anadea “How Effective A/B Testing Helps to Build a Cool Real Estate App”.

StreetEasy, una piattaforma immobiliare con sede a New York, ha riconosciuto le preferenze uniche del suo pubblico. Ha condotto un test A/B per determinare i filtri di ricerca più efficaci per i suoi utenti e ha scoperto che gli utenti preferivano cercare per quartieri e tipi di edifici. A New York, la posizione di un appartamento e il tipo di edificio in cui si trova possono influenzare notevolmente la decisione di un potenziale acquirente o affittuario. Ad esempio, chi è abituato a vivere a Tribeca potrebbe non essere interessato a un appartamento a Chinatown, anche se soddisfa tutti gli altri criteri.

Oltre ai filtri di ricerca, anche la rappresentazione visiva degli annunci è fondamentale per i potenziali acquirenti. I visitatori passano circa il 60% del loro tempo a guardare le foto degli annunci, rendendo le dimensioni di queste immagini un fattore significativo per il coinvolgimento degli utenti e i tassi di conversione.

Inoltre, la descrizione che accompagna un annuncio può influenzare la decisione di un potenziale acquirente. Zillow ha condotto uno studio analizzando 24.000 vendite di case e ha scoperto che alcune parole nelle descrizioni degli annunci portavano a vendere le case a prezzi più alti del previsto. Parole come “lussuoso”, “paesaggistico” e “migliorato” sono risultate in grado di aumentare i tassi di conversione.

Get 111 Landing Page Examples—The Ultimate Guide for FREE

4. Esempio di test A/B per applicazioni mobili

Il quarto dei nostri esempi di A/B testing riguarda un’applicazione mobile, vista la crescente tendenza all’ottimizzazione delle applicazioni mobili. AppQuantum e Red Machine hanno collaborato a un’ampia campagna di A/B testing per l’applicazione Doorman Story, un gioco di simulazione di gestione del tempo in cui i giocatori gestiscono il proprio hotel. L’esempio è stato descritto nell’articolo “How to Conduct A/B Tests in Mobile Apps: Part I”, pubblicato sul sito web di Medium.

Il team di AppQuantum ha deciso di verificare se l’introduzione di una meccanica di gioco a pagamento, nello specifico una macchina per le gomme da masticare, potesse essere una strategia di monetizzazione redditizia. Ciò significa vendere meccaniche di gioco esistenti che altri giochi offrono solitamente gratuitamente. Hanno introdotto questa esclusiva meccanica di gioco a pagamento in una serie specifica di livelli, assicurandosi che non alterasse l’equilibrio generale del gioco.

Lo scopo del test A/B era quello di valutare il valore di questa nuova meccanica per i giocatori. È stato introdotto un paywall per misurare le reazioni degli utenti e determinare se l’acquisto fosse ritenuto valido. Tuttavia, il rischio principale era che i giocatori potessero essere scoraggiati dal dover pagare per strumenti che prima erano gratuiti.

Dopo aver condotto il test A/B, i risultati hanno mostrato che la meccanica più semplificata è stata quella di maggior successo. Questo risultato inaspettato ha sottolineato l’importanza dei test A/B nelle applicazioni mobili, dimostrando che a volte le soluzioni più semplici possono dare i risultati migliori.

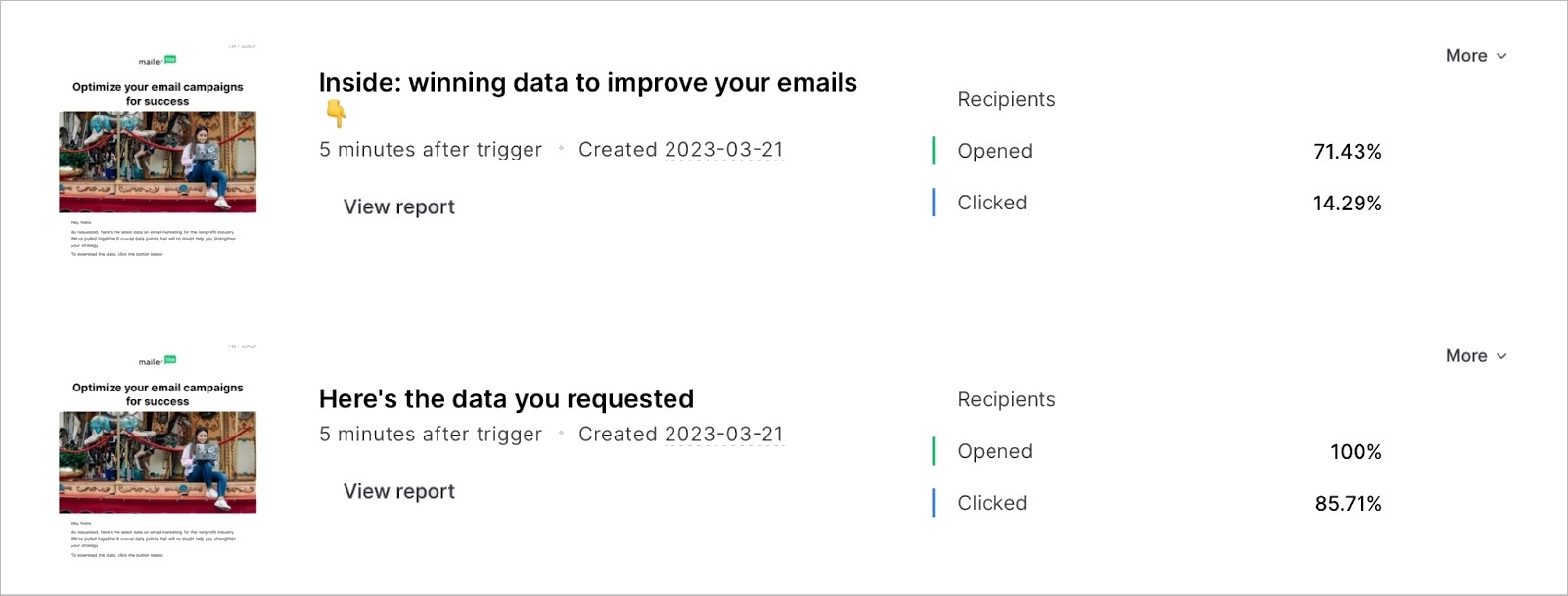

5. Esempio di test A/B di email marketing

Esempi intriganti di A/B testing provengono da MailerLite, descritti nell’articolo di Jonas Fischer “Esempi di A/B testing dell’email marketing per migliorare campagne, landing page e altro”. Il team di MailerLite ha condotto diversi test A/B nel corso degli anni per determinare l’efficacia dell’uso di emoji negli oggetti delle e-mail, la lunghezza degli oggetti, l’inizio dell’oggetto con una domanda, il posizionamento di immagini e GIF e l’automazione dei test.

Esaminiamo le prime due opzioni per avere una visione più approfondita dei test A/B di email marketing. Inizialmente, il team di MailerLite ha testato gli emoji nelle righe dell’oggetto e i risultati non sono stati molto promettenti. Nel 2020, il tasso di apertura di un oggetto con emoji era del 31,82%, mentre senza emoji era del 31,93%. Tuttavia, con il passare del tempo, sono stati condotti altri split test A/B e si è constatato che le emoji nell’oggetto erano più efficaci per il pubblico. Test recenti hanno dimostrato che le emoji nell’oggetto hanno un impatto positivo significativo sui tassi di apertura. Il tasso di apertura di un oggetto con emoji è stato del 37,33%, rispetto al 36,87% senza emoji.

I test sulla lunghezza dell’oggetto hanno anche dimostrato che può influenzare il coinvolgimento nelle e-mail. MailerLite ha riscontrato che gli oggetti concisi sono più efficaci nell’attirare i clic degli abbonati. Il test ha dimostrato che gli oggetti più brevi possono raggiungere un tasso di apertura del 100% e un tasso di clic dell’85,71%.

6. Esempio di test A/B per il commercio elettronico

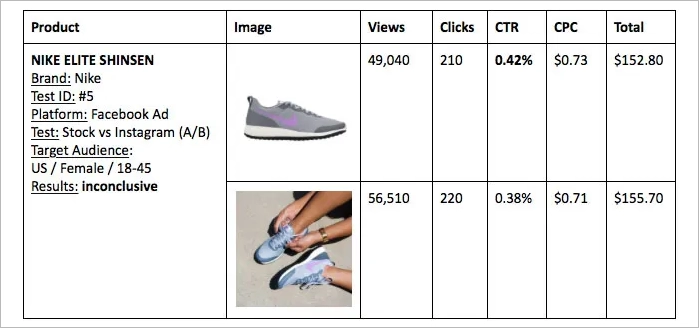

L’articolo intitolato “The Battle of Conversion Rates – User Generated Content vs Stock Photos” (La battaglia dei tassi di conversione – Contenuti generati dagli utenti e foto di repertorio) di Tomer Dean ha analizzato l’efficacia dei contenuti generati dagli utenti (UGC) rispetto alle foto di repertorio nel settore dell’e-commerce. Una vasta campagna di test A/B ha riguardato principalmente articoli di moda e abbigliamento, confrontando immagini di persone reali che indossano i prodotti con foto di stock scattate professionalmente.

In uno dei test, l’immagine stock di un reggiseno sportivo Nike è stata messa a confronto con un’immagine generata dagli utenti su Instagram. I risultati sono stati interessanti: l’immagine UGC ha raggiunto un tasso di conversione dello 0,90% rispetto allo 0,31% della foto stock. Test simili sono stati condotti per altri prodotti, come una gonna di Zara e scarpe da corsa di Nike, con risultati diversi. In un altro esperimento riguardante i tacchi rossi, una pagina di destinazione che mostrava l’immagine stock insieme a tre immagini UGC ha superato in modo significativo la pagina con la sola immagine stock.

I test A/B hanno evidenziato il potenziale dell’UGC nel migliorare i tassi di conversione. Tuttavia, l’articolo ha anche sottolineato l’importanza di effettuare test continui e di rispettare le norme sul copyright quando si reperiscono le immagini.

Ciò che è ancora più affascinante è che i siti di e-commerce generano un fatturato medio di 3 dollari per visitatore unico, e un A/B test di successo di solito aumenta questa cifra fino al 50%, come illustrato nell’articolo di Smriti Chawla “CRO Industry Insights from Our In-App Survey Results” sul sito web di VWO.

Il test A/B può essere applicato a ogni elemento di un sito web?

Sebbene l’A/B testing possa essere applicato a qualsiasi elemento di un sito web, è fondamentale dare priorità e concentrarsi sugli elementi che hanno un impatto significativo sul comportamento degli utenti e sui tassi di conversione. Testando e ottimizzando sistematicamente gli elementi chiave, le aziende possono massimizzare i vantaggi dei test A/B e prendere decisioni basate sui dati che portano a migliorare l’esperienza degli utenti e ad aumentare i ricavi.

C’è il rischio di allontanare gli utenti con frequenti test A/B?

Se non vengono pianificati ed eseguiti con attenzione tenendo conto dell’esperienza e delle preferenze degli utenti, i frequenti test A/B possono potenzialmente allontanare gli utenti. È importante trovare un equilibrio tra i test e il mantenimento di un’esperienza utente coerente.

Che cos’è un gruppo di controllo nei test A/B?

Nei test A/B, il gruppo di controllo si riferisce alla versione originale di una pagina web o di un’applicazione, che serve come base di confronto con la variazione. Il gruppo di controllo serve come punto di riferimento per valutare l’impatto delle modifiche apportate alla versione di test.

Cosa costituisce un risultato statisticamente significativo nei test A/B?

I risultati statisticamente significativi nei test A/B indicano un alto livello di fiducia che la differenza osservata tra il controllo e la variazione non sia dovuta al caso. Il livello di significatività statistica è in genere fissato al 95%, il che significa che esiste solo il 5% di possibilità che la differenza osservata sia dovuta alla casualità.

Quale percentuale di test A/B/x fallisce?

Secondo CRO Industry Insights di Smriti Chawla di VWO, circa il 14% dei test A/B sono test vincenti in modo statisticamente significativo, il che significa che l’86% non riesce a migliorare i tassi di conversione. La ricerca di Convert.com ha dato risultati simili per quanto riguarda l’impatto sulla conversione. Tuttavia, il tasso di fallimento può variare a seconda del settore e della complessità del test.

Quali sono gli strumenti più utilizzati per i test A/B?

Per aiutare le aziende a ottimizzare la loro presenza digitale sono disponibili diversi strumenti di A/B testing, come ad esempio:

- Ottimizzare

- VWO

- Ottimizzare Google

- Obiettivo Adobe

- AB Gustoso

Questi strumenti offrono diverse caratteristiche e funzionalità che consentono alle aziende di progettare, gestire e analizzare i test A/B in modo efficace.

Cosa ha un impatto più profondo sul comportamento dell’utente: cambiare il colore della CTA o il suo testo?

Il testo della CTA è spesso più critico, poiché comunica direttamente l’azione desiderata. Tuttavia, sia il colore che il testo possono avere un impatto sul comportamento degli utenti. Secondo uno studio, “The Button Color A/B Test: Red Beats Green” condotto da Joshua Porter di Hubspot, la modifica del colore di un pulsante call-to-action può portare a un aumento del 21% delle conversioni. D’altra parte, la ricerca di Melanie Deziel “How to Build and Optimize CTA Buttons That Convert” suggerisce che il testo personalizzato della call-to-action può migliorare i tassi di conversione fino al 202%. Detto questo, mentre cambiare la tavolozza dei colori può rendere il pulsante CTA più attraente dal punto di vista visivo, modificare il testo può avere un impatto significativo sul comportamento degli utenti e portare a conversioni più elevate.

Quali sono i settori che beneficiano maggiormente dei test A/B?

I settori che traggono i maggiori vantaggi dai test A/B sono i seguenti:

- Commercio elettronico

- SaaS

- Marketing digitale

- Sviluppo di applicazioni mobili

Le aziende di questi settori possono migliorare significativamente la loro presenza digitale e ottenere una crescita implementando lo split test per ottimizzare l’esperienza dell’utente, migliorare i tassi di conversione e consentire decisioni basate sui dati.

Che cos’è l’A/B testing nell’esempio del marketing?

L’A/B testing nel marketing consiste nel confrontare diverse strategie di marketing, creazioni pubblicitarie o messaggistica per determinare quella che produce risultati migliori. Testando sistematicamente diverse varianti di campagne di marketing, le aziende possono identificare quali approcci hanno una maggiore risonanza con il loro pubblico di riferimento e quali risultano in un maggiore coinvolgimento e conversioni. Inoltre, l’esecuzione di un maggior numero di test consente una comprensione più completa di ciò che funziona e di ciò che non funziona, permettendo così di prendere decisioni di marketing più accurate ed efficaci.

Qual è un esempio di A/B testing sui social media?

L’A/B testing sui social media consiste nel confrontare diverse creatività di annunci, opzioni di targeting o formati di post. Ad esempio, un’azienda potrebbe testare due diverse immagini per un annuncio su Facebook, insieme a diverse opzioni di targeting, per individuare quale combinazione produce un maggiore coinvolgimento e conversioni.

Perché usiamo i test A/B?

I test A/B vengono utilizzati per facilitare le decisioni basate sui dati, ottimizzare l’esperienza degli utenti e migliorare i tassi di conversione. Testando sistematicamente diverse varianti di pagine web, applicazioni e campagne di marketing, gli esperti di marketing possono perfezionare le loro campagne, massimizzare il ritorno sugli investimenti e assicurarsi di rimanere davanti alla concorrenza e di crescere.

Il test A/B è un KPI?

L’A/B testing può essere considerato un KPI in quanto aiuta a misurare l’efficacia delle modifiche apportate a un sito web o a un’applicazione e il loro impatto sul comportamento degli utenti e sulle conversioni. Testando sistematicamente diverse varianti e analizzando i risultati, le aziende possono identificare le strategie e gli elementi più efficaci che favoriscono le conversioni.

Qual è un esempio di A/B testing nella vita reale?

Esempi reali di A/B testing sono la verifica di diverse strategie di prezzo, di confezionamento dei prodotti o di layout dei negozi per ottimizzare le vendite e la soddisfazione dei clienti. Confrontando diverse versioni di queste variabili, le aziende possono identificare quali cambiamenti portano a un aumento delle vendite e a una migliore esperienza del cliente.

Cosa sono i campioni A/B?

I campioni A/B si riferiscono alle due versioni (controllo e variazione) di una pagina web o di un’applicazione in fase di test. Confrontando le prestazioni di questi campioni, è possibile identificare la versione più performante e ottimizzare la propria presenza digitale.

Quante aziende utilizzano i test A/B?

Secondo un’indagine del 2020 del CXL Institute, “State of Conversion Optimization”, circa il 44% delle aziende utilizza software di A/B testing. L’indagine è stata condotta su 333 aziende di varie dimensioni, dalle piccole startup alle grandi aziende, in diversi settori.

L’uso dei test A/B è più diffuso tra le aziende con una forte presenza online, come le aziende di e-commerce e SaaS. Ad esempio, un rapporto di Econsultancy sulla Conversion Rate Optimization del 2019 ha rivelato che il 77% delle aziende che hanno un approccio strutturato al miglioramento dei tassi di conversione utilizza in qualche misura i test A/B.

Come utilizza Netflix i test A/B?

Netflix utilizza i test A/B per migliorare la propria esperienza utente, testando diverse interfacce utente, algoritmi di raccomandazione, miniature per spettacoli e film e altro ancora. L’obiettivo è determinare quali variazioni gli utenti preferiscono e quali portano a un maggiore coinvolgimento e a tempi di visione più lunghi.

YouTube dispone di test A/B?

YouTube non fornisce strumenti di test A/B per i creatori. Tuttavia, YouTube stesso conduce test A/B sulla propria piattaforma per ottimizzare l’esperienza utente e le funzionalità. Se i creatori vogliono condurre test A/B sui loro contenuti, devono utilizzare strumenti o metodi esterni.

Shopify dispone di test A/B?

Shopify supporta i test A/B, ma non dispone di una funzione integrata. Tuttavia, nell’app store di Shopify sono disponibili diverse applicazioni di terze parti che consentono di eseguire test.

Mailchimp può effettuare test A/B?

Sì, Mailchimp offre funzioni di A/B testing. Permette agli utenti di testare diversi oggetti, contenuti e tempi di invio per ottimizzare le campagne e-mail.

Wix può fare test A/B?

Wix non ha una funzione di test A/B integrata, ma strumenti di terze parti come Google Optimize possono essere integrati per effettuare test A/B sui siti web Wix. Le aziende che utilizzano Wix possono condurre test A/B per ottimizzare i loro siti web, migliorare l’esperienza degli utenti e aumentare i tassi di conversione sfruttando questi strumenti.

Google effettua test A/B?

Sì, Google effettua spesso split test per valutare le modifiche e i miglioramenti ai suoi prodotti, servizi e algoritmi. Questo aiuta Google a garantire che qualsiasi nuova funzionalità o modifica fornisca un’esperienza utente positiva e raggiunga gli obiettivi prefissati.

Come effettuare i test A/B con Google Ads?

Per condurre test A/B con Google Ads, seguite questi quattro passaggi:

- Identificate l’elemento che desiderate testare (copia dell’annuncio, pagina di destinazione, parole chiave ecc.).

- Create due versioni del vostro annuncio, una con l’elemento originale e una con l’elemento modificato.

- Eseguite entrambi gli annunci contemporaneamente per un periodo prestabilito.

- Analizzate i dati di performance di entrambi gli annunci per determinare quale versione offre risultati migliori.

Come condurre un test A/B in Excel?

È possibile condurre un test A/B in Excel organizzando i dati in due gruppi: A (controllo) e B (test). Calcolate la media e la deviazione standard per entrambi i gruppi. Quindi, utilizzate la funzione t-test di Excel per confrontare le medie dei due gruppi e determinare se c’è una differenza statisticamente significativa.

Quanti dati sono necessari per il test A/B?

Fattori come il livello di significatività statistica desiderato, la dimensione dell’effetto atteso e il traffico verso la pagina o l’applicazione testata influenzano la quantità di dati necessari per un A/B test. In genere, per ottenere un test più affidabile, si raccomanda un campione di dimensioni maggiori; alcuni specialisti del settore suggeriscono un campione minimo di 100 conversioni per variazione.

Per determinare la quantità adeguata di dati necessari, è necessario tenere conto anche del contesto e degli obiettivi specifici del test A/B.

I test A/B sono costosi?

Il costo dei test A/B dipende dagli strumenti utilizzati, dalla complessità dei test e dal fatto che vengano condotti internamente o in outsourcing. Alcuni strumenti online offrono servizi di base gratuiti, mentre altri possono richiedere un canone mensile.

Conclusione

L’A/B testing non è solo uno strumento, ma una mentalità di miglioramento e adattamento continuo. Permette ai marketer di prendere decisioni informate, supportate da dati, per perfezionare le loro strategie e ottenere risultati ottimali. Che si tratti di modificare un pulsante CTA, di sperimentare il design di una landing page o di testare le variazioni di una campagna e-mail, il test A/B è una risorsa inestimabile nel kit di strumenti del marketer. Man mano che ci addentriamo nell’era digitale, il ruolo dello split testing nel plasmare le esperienze degli utenti e nel guidare il successo aziendale diventa sempre più fondamentale.

Piattaforme come Landingi hanno democratizzato l’accesso a questo potente strumento, consentendo alle aziende di tutte le dimensioni di condurre esperimenti approfonditi. Con Landingi, è possibile creare una grande campagna e ottimizzarla con test multivariati, programmatore di campagne, sostituzione dinamica del testo e opzioni di personalizzazione per ottenere i migliori risultati. La cosa più interessante è che potete iniziare a utilizzare la piattaforma Landingi gratuitamente!