Zrozumienie zachowań użytkowników i optymalizacja ich doświadczeń to podstawa powodzenia w realiach dzisiejszego Internetu. Testy A/B, znane również jako testy dzielone lub testy porównawcze, stały się rozwiązaniem niezbędnym do osiągnięcia tego celu. Pomocą w tej kwestii są takie platformy do tworzenia stron i landing page’y, takie jak Landingi, które uprościły proces testowania witryn, czyniąc go bardziej dostępnym dla firm.

W tym artykule omówimy sześć rzeczywistych przykładów i case studies testów A/B, które pokazują transformacyjną moc testów dzielonych. Zbadamy, w jaki sposób pozornie niewielkie modyfikacje mogą prowadzić do znacznej poprawy konwersji. Przedstawimy również nieoczekiwane wyniki, które mogą pojawić się w wyniku takich eksperymentów, udowadniając, że czasami najbardziej niepozorne zmiany mogą przynieść najbardziej efektywne rezultaty. Omówimy typowe pułapki w testach porównawczych, w tym pośpieszne procesy, lekceważenie istotności statystycznej i wprowadzanie zmian na podstawie niejednoznacznych wyników.

Co to są testy A/B?

Testy A/B to metoda, która pomaga podejmować decyzje oparte na danych poprzez porównywanie różnych wersji strony internetowej lub aplikacji w celu ustalenia, która z nich działa lepiej. Często obejmuje testowanie wielu wariantów stron (testy A/B/x) z myślą o optymalizacji doświadczenia użytkownika i współczynników konwersji.

W artykule Adeliny Karpenkovej “A/B Testing in Marketing: The Best Practices Revealed” można przeczytać, że testowanie jest integralnym elementem procesu optymalizacji współczynnika konwersji (CRO). Definicja testów A/B wskazuje na badanie reakcji podobnych odbiorców na dwie wersje identycznej treści, gdzie jedyna różnica polega na jednej zmiennej.

Z kolei według artykułu CXL “5 Things We Learned from Analyzing 28,304 Experiments” autorstwa Dennisa van der Heijdena takie eksperymenty są podstawowym badaniem dla większości specjalistów ds. optymalizacji, a testy A/B stanowią 97,5% wszystkich eksperymentów na platformie CXL. Testy dzielone zyskały popularność ze względu na ich potencjał do osiągania powtarzalnych sukcesów, zwiększania przychodów i optymalizacji wskaźnika konwersji.

Gdzie stosuje się testy A/B?

Testy A/B mają zastosowanie w różnych sektorach. Okazują się być rewolucyjne zwłaszcza w takich dziedzinach jak:

- ecommerce,

- SaaS,

- wydawnictwa,

- aplikacje mobilne,

- e-mail marketing,

- media społecznościowe.

Utworzenie nowej wersji istniejącej strony i porównanie jej wyników z oryginałem pozwala firmom zwiększyć współczynniki konwersji i zoptymalizować swoją obecność w Internecie dzięki informacjom o rzeczywistych zachowaniach i preferencjach użytkowników. Może to być szczególnie przydatne w przypadku zarządzania wieloma stronami w obrębie jednej witryny.

Jakie są zalety testów A/B?

Zalety testów A/B pozwalają wyeliminować zgadywanie, podejmować decyzje w oparciu o konkretne dowody, optymalizować widoczność online i ostatecznie – osiągać lepsze wyniki. Korzyści płynące z testów porównawczych można podzielić na 10 poniższych kategorii:

- Lepsze doświadczenie użytkownika (UX): Testując różne warianty treści, designu lub funkcji, można określić, która wersja dostarcza lepszych wrażeń użytkownikom, co prowadzi do ich większej satysfakcji.

- Decyzje oparte na danych: Testy A/B dostarczają konkretnych danych na temat tego, co działa najlepiej dla odbiorców, eliminując potrzebę polegania na przeczuciach lub założeniach. Pozwala to na podejmowanie bardziej świadomych decyzji.

- Wyższe współczynniki konwersji: Identyfikując, która wersja strony internetowej lub funkcji prowadzi do lepszych współczynników konwersji, można zoptymalizować witryny w celu zwiększenia sprzedaży, rejestracji lub innych pożądanych działań.

- Redukcja współczynnika odrzuceń: Jeśli użytkownicy uznają treść lub układ za bardziej angażujący lub łatwiejszy w nawigacji, jest mniej prawdopodobne, że szybko opuszczą witrynę – a to zmniejsza współczynnik odrzuceń. Na przykład może się okazać, że użytkownicy mobilni wolą inny layout lub prezentację treści, więc ich implementacja zmniejszy współczynnik odrzuceń na smartfonach i tabletach.

- Opłacalność: Wiele przykładów testów A/B pokazuje, jak przeprowadzanie takich prób może zapobiec kosztownym błędom. Testując zmiany przed ich pełnym wdrożeniem, firmy mogą uniknąć inwestowania w funkcje lub projekty, które nie rezonują z odbiorcami.

- Zmniejszenie ryzyka: Wprowadzanie dużych zmian bez testowania może być ryzykowne. Testy A/B pozwalają najpierw wypróbować zmiany na mniejszej grupie odbiorców, zmniejszając potencjalny negatywny wpływ wdrożenia na pełną skalę.

- Większe zaangażowanie w treść: Eksperymentowanie z różnymi nagłówkami, obrazami lub układami treści może pomóc określić, co sprawia, że użytkownicy są zaangażowani przez dłuższy czas.

- Lepszy zwrot z inwestycji: W przypadku firm wydających pieniądze na kampanie reklamowe lub marketingowe, testy A/B mogą sprawić, że landing page będą zoptymalizowane pod kątem konwersji, prowadząc do lepszego zwrotu z inwestycji (ROI).

- Zrozumienie preferencji odbiorców: Z biegiem czasu konsekwentne testy A/B dostarczają wglądu w preferencje i zachowania odbiorców, pozwalając na lepiej ukierunkowane treści i strategie marketingowe.

- Ciągłe doskonalenie: Testy dzielone wspierają kulturę ciągłego doskonalenia, zgodnie z którą firmy zawsze szukają sposobów na optymalizację i poprawę swojej obecności w Internecie.

Raport CXL “State of Conversion Optimization 2020” wskazuje, że testy A/B są drugą najlepszą strategią optymalizacji konwersji. Ponadto, jak podkreśla Smriti Chawla w raporcie VWO “CRO Industry Insights from Our In-App Survey Results”, statystycznie istotne testy zwiększają współczynniki konwersji średnio o 49%.

Jakie są wady testów A/B?

Podstawową wadą testów A/B jest ryzyko zrażenia użytkowników, jeśli testy są przeprowadzane zbyt często lub bez odpowiedniego przygotowania. Nieodpowiednie testy mogą prowadzić do niespójnych doświadczeń użytkowników, co może skutkować ich niezadowoleniem.

Częste pułapki w testach wielowariantowych obejmują pośpieszne procesy, lekceważenie znaczenia statystycznego i wprowadzanie zmian w oparciu o niejednoznaczne wyniki testów. Pośpieszne procesy mogą prowadzić do źle zaprojektowanych testów, podczas gdy lekceważenie istotności statystycznej może skutkować decyzjami opartymi na losowym przypadku, a nie rzeczywistym efekcie. Wprowadzanie zmian na podstawie niejednoznacznych wyników może z kolei powodować zamieszanie i prowadzić do mylących danych.

Na każdy test należy przeznaczyć odpowiednią ilość czasu, zapewnić wystarczającą wielkość próby do uzyskania istotności statystycznej i powstrzymać się od wprowadzania zmian do czasu uzyskania jednoznacznych i istotnych statystycznie wyników.

Elementy najczęściej sprawdzane w testach A/B

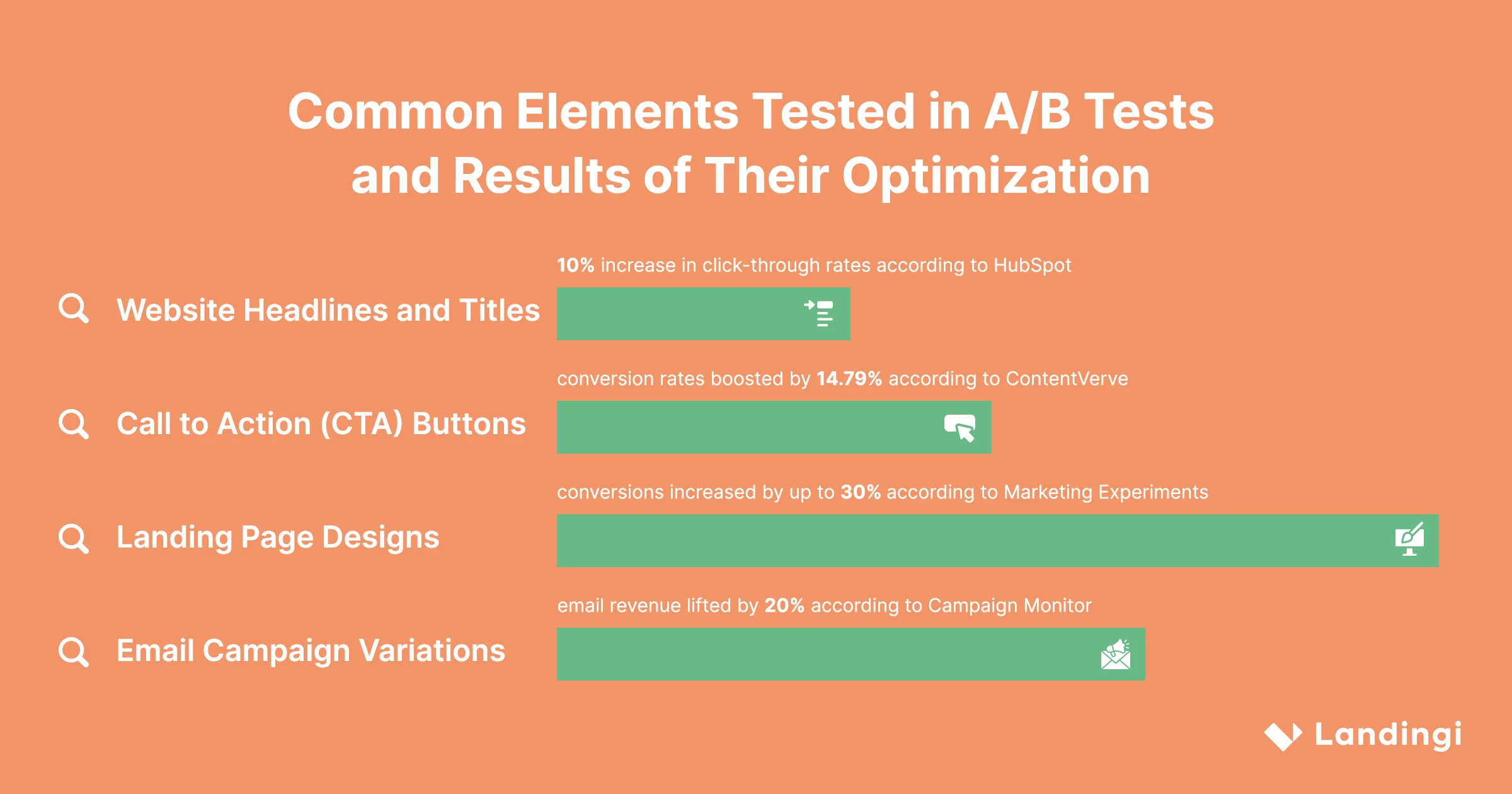

Do najczęściej sprawdzanych elementów w testach A/B należą:

- Nagłówki i tytuły

- Przyciski wezwania do działania (CTA)

- Wygląd landing page’y

- Warianty kampanii e-mail

Wiele przykładów eksperymentowania obejmuje również formularze rejestracji, sekcje dowodu społecznego i teksty reklam. Kluczem do udanego testu wielowariantowego jest skupienie się na tych elementach, które mają największy wpływ na zachowanie użytkowników i współczynnik konwersji.

Przyjrzyjmy się bliżej najpopularniejszym elementom.

Nagłówki i tytuły stron internetowych

Przyciągający uwagę nagłówek odgrywa ogromną rolę w zainteresowaniu i zatrzymaniu odwiedzających witrynę. Testy A/B pozwalają eksperymentować z różnymi nagłówkami i tytułami, aby określić, które z nich lepiej rezonują z docelowymi odbiorcami. Modyfikując czynniki, takie jak sformułowania, przekaz i styl, można zoptymalizować tekst pod kątem wyższych współczynników klikalności, większego zaangażowania i lepszych wyników witryny.

Według Hubspot eksperymentowanie z nagłówkami i tytułami może przyczynić się do zwiększenia współczynnika klikalności nawet o 10%.

Przyciski wezwania do działania (CTA)

Przyciski CTA to elementy decydujące o konwersji. Testowanie A/B pozwala na porównanie różnych wersji CTA w celu określenia, która z nich daje lepsze wyniki klikalności. Zmieniając wygląd, kolor, rozmiar, tekst lub położenie przycisków, można wpłynąć na zachowanie użytkowników i zwiększyć skuteczność wezwania do działania.

ConvertVerve udowodnił, że testowanie przycisków pozwala zwiększyć współczynnik konwersji o 14,79%.

Wygląd landing page’y

Dobrze zaprojektowana strona docelowa znacząco poprawić doświadczenie użytkownika i współczynnik konwersji. W testach wielowariantowych najczęściej modyfikowane elementy landing page’y obejmują:

- Układ strony

- Nagłówki

- Podtytuły

- Treść strony

- Cenniki

- Przyciski

- Proces rejestracji

- Długość formularza

- Elementy graficzne

Eksperymentowanie z różnymi wariantami stron docelowych ma kluczowe znaczenie dla optymalizacji jakości potencjalnych klientów i współczynników konwersji. Testując różne projekty, można określić, które elementy rezonują z odbiorcami i prowadzą do pożądanych działań, a które mogą powodować zakłócenia lub dezorientację. Ten proces ciągłego doskonalenia może znacznie poprawić ogólną wydajność landing page’a.

Eksperymenty marketingowe wykazały, że optymalizacja projektu strony docelowej zwiększa konwersje nawet o 30%.

Landingi, cieszący się uznaniem kreator landing page’y, oferuje mnóstwo funkcji, które zaspokajają tę właśnie potrzebę. Dzięki intuicyjnemu interfejsowi i możliwościom testowania, Landingi ułatwia tworzenie, duplikowanie, modyfikowanie, przeprowadzanie testów i optymalizację landing page’y.

Warianty kampanii e-mail

Kampanie e-mailowe to potężne narzędzie marketingowe, a testy A/B mogą pomóc zoptymalizować je dla uzyskania maksymalnego efektu. Tworząc i porównując wiele wersji wiadomości, można określić, które warianty lepiej trafiają do odbiorców docelowych i prowadzą do wyższych wskaźników otwarć i kliknięć.

Testy A/B to nieocenione narzędzie, które pozwala udoskonalić strategię marketingu e-mailowego w oparciu o rzeczywiste zachowania i preferencje użytkowników.

Dla przykładu wyobraźmy sobie firmę sprzedającą online ręcznie robioną biżuterię. Może ona wykorzystać testy dzielone, aby znaleźć najskuteczniejszy temat wiadomości e-mail. Tworzy dwie wersje tego samego e-maila, różniące się jedynie tytułem. Jeden e-mail może być zatytułowany “Nowa kolekcja: Ręcznie robiona biżuteria specjalnie dla Ciebie”, a drugi “Odkryj swój nowy ulubiony klejnot”. Wysyłając te wiadomości do różnych podgrup odbiorców, firma może śledzić, który e-mail ma wyższy wskaźnik otwarć. Najbardziej skuteczny temat zostanie następnie wykorzystany w przyszłych newsletterach, potencjalnie prowadząc do zwiększenia zaangażowania i sprzedaży.

Według Campaign Monitor zróżnicowanie kampanii e-mailowych może zwiększyć przychody ze sprzedaży o 20%.

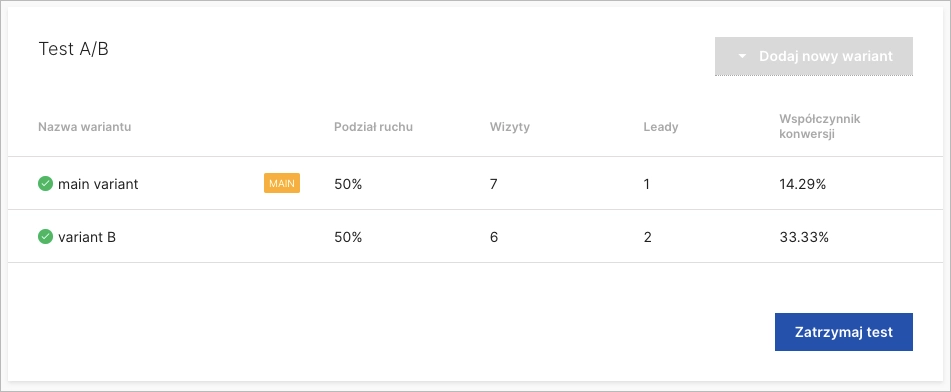

1. Przykład testu A/B landing page’a

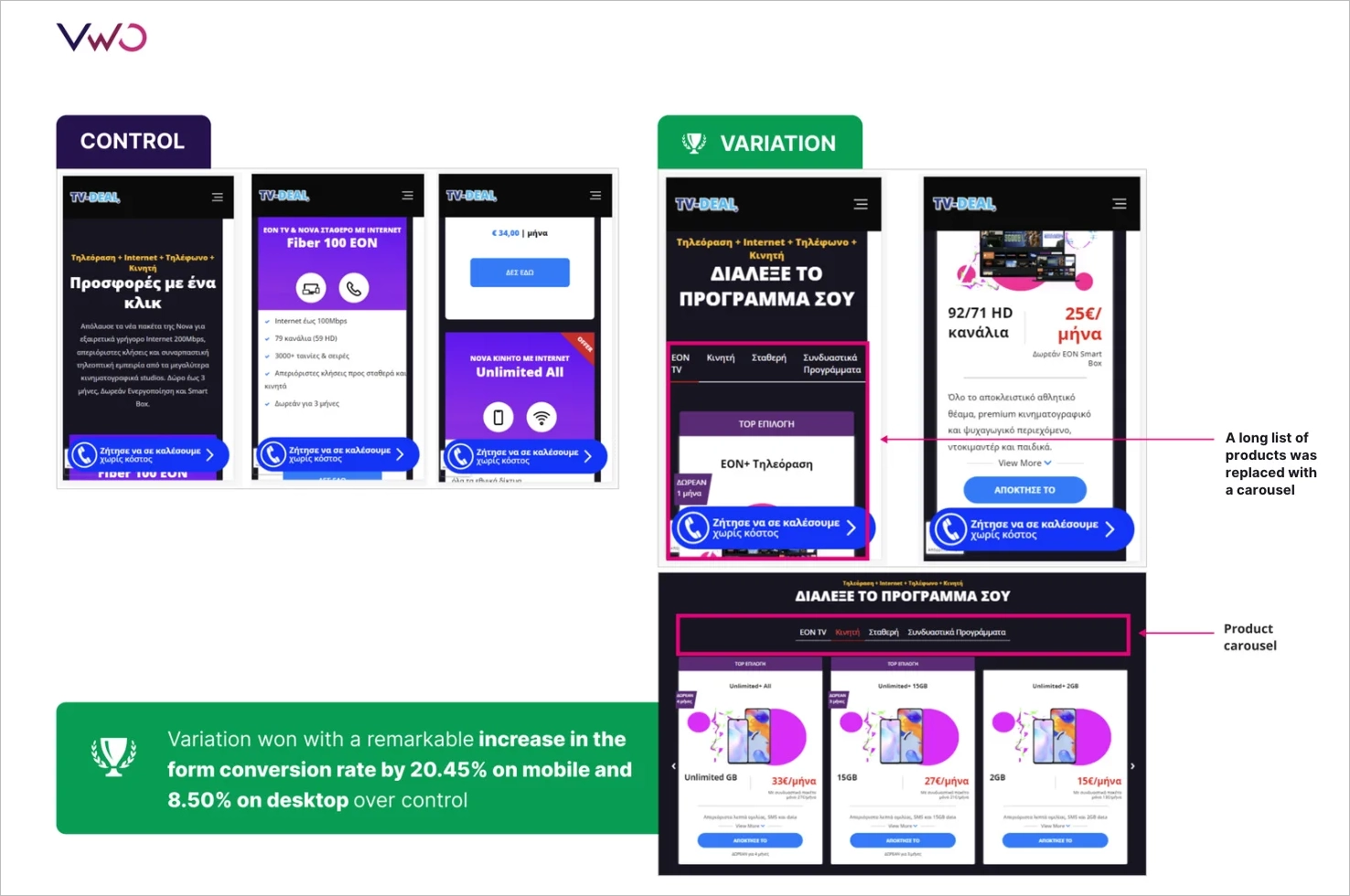

Pierwszy z naszych przykładów testów A/B dotyczy landing page’a – biorąc pod uwagę, że jest to typ strony internetowej regularnie testowanej przez marketerów. ForestView, agencja z siedzibą w Grecji, prowadziła szeroko zakrojoną kampanię testów A/B, aby zoptymalizować landing page swojego klienta.

Zespół ForestView postawił hipotezę, że zmniejszenie zakresu wymaganego scrollowania strony pomogłoby użytkownikom łatwiej znaleźć preferowany produkt, co doprowadziłoby do poprawy współczynnika konwersji formularza. Aby sprawdzić tę hipotezę, przeprowadzono test A/B z przeprojektowaną stroną docelową. Nowy projekt obejmował wielopoziomowe filtrowanie umożliwiające użytkownikom dynamiczne znajdowanie pożądanego produktu i zastąpił długą listę produktów karuzelami.

Test A/B był prowadzony przez 14 dni, a ponad 5000 odwiedzających podzielono równo między grupę kontrolną i wariacyjną. Wyniki pokazały, że drugi wariant okazał się lepszy od kontrolnego, a wielopoziomowe filtrowanie i karuzela zwiększyły współczynnik konwersji formularza o 20,45% na urządzeniach mobilnych i 8,50% na komputerach stacjonarnych. Dodatkowo zaangażowanie użytkowników wzrosło o 70,92%.

2. Przykład testu A/B dla SaaS

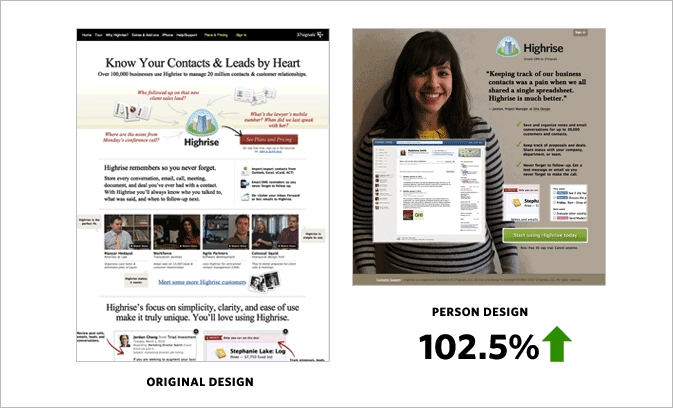

W branży SaaS testy A/B mają ogromną wartość w optymalizacji projektów stron internetowych. Artykuł Basecamp’s Signal v. Noise opisał konkretne zalety testów porównawczych dla witryny marketingowej Highrise.

Zespół postawił hipotezę, że zwięzły projekt, nazwany “Person Page”, będzie bardziej atrakcyjny dla użytkowników i spowoduje wyższe współczynniki konwersji. Aby przetestować tę teorię, przeprowadzono test A/B, w którym porównano “Person Page” z projektem “Long Form”. Wyniki pokazały, że strona “Person Page” miała 47% wzrostu w płatnych rejestracjach (102,5% wzrostu w porównaniu do oryginalnego projektu). Jednak po dodaniu dodatkowych informacji do projektu jej skuteczność spadła o 22%.

W innym eksperymencie zespół przeanalizował wpływ zdjęć klientów na konwersje. Odkryli, że duże, radosne zdjęcia klientów zwiększały konwersje, natomiast znaczenia nie miała już konkretna osoba przedstawiona na zdjęciu.

Zespół spędził kilka tygodni, przeprowadzając testy A/B, dokładnie analizując zachowania i preferencje użytkowników. Głównym wnioskiem z eksperymentów było to, że testy są cennym narzędziem, które może obalić założenia i ujawnić elementy projektu, które naprawdę trafiają do użytkowników.

3. Przykład testu A/B w branży nieruchomości

Branża nieruchomości, podobnie jak wiele innych, w dużym stopniu polega na skuteczności swoich platform cyfrowych. Giganci z sektora nieruchomości, tacy jak Zillow, Trulia i StreetEasy, rozumieją znaczenie ciągłego udoskonalania doświadczeń użytkowników, aby zaspokoić potrzeby odbiorców. Osiągają to poprzez przeprowadzanie testów A/B, co opisano w artykule Anadea “How Effective A/B Testing Helps to Build a Cool Real Estate App”.

StreetEasy, platforma nieruchomości z siedzibą w Nowym Jorku, postanowiła poznać unikalne preferencje swoich odbiorców. Przeprowadziła testy A/B w celu określenia najskuteczniejszych filtrów wyszukiwania dla swoich użytkowników i odkrła, że użytkownicy najchętniej szukają po dzielnicach i typach budynków. Wniosek: w Nowym Jorku lokalizacja mieszkania i rodzaj budynku, w którym się ono znajduje, mogą znacząco wpłynąć na decyzję potencjalnego nabywcy lub najemcy. To znaczy, że osoba przyzwyczajona do mieszkania w Tribece może nie być zainteresowana mieszkaniem w Chinatown, nawet jeśli spełnia ono wszystkie inne kryteria.

Oprócz filtrów wyszukiwania znaczenie dla potencjalnych nabywców ma również wizualna prezentacja ofert. Odwiedzający spędzają około 60% czasu na oglądaniu zdjęć ogłoszeń, a rozmiar tych obrazów jest istotnym czynnikiem wpływającym na zaangażowanie użytkowników i współczynniki konwersji.

Co więcej, opis towarzyszący ofercie może wpłynąć na decyzję potencjalnego kupca. Zillow przeprowadził badanie analizujące 24 000 transakcji i odkrył, że niektóre słowa w opisach prowadziły do sprzedaży domów po wyższych cenach niż oczekiwano. Okazało się, że wyrażenia takie jak “luksusowy”, “zagospodarowany” i “ulepszony” zwiększają wskaźniki konwersji.

4. Przykład testu A/B aplikacji mobilnej

Czwarty z naszych przykładów testów A/B dotyczy aplikacji mobilnej. To ważna analiza, biorąc pod uwagę rosnący trend optymalizacji aplikacji komórkowych. AppQuantum i Red Machine współpracowały przy szeroko zakrojonej kampanii testów A/B dla swojej aplikacji Doorman Story, która jest grą symulacyjną zarządzania czasem, w której gracze kierują własnym hotelem. Przykład ten został opisany w artykule “How to Conduct A/B Tests in Mobile Apps: Part I” opublikowanym na łamach serwisu Medium.

Zespół AppQuantum postanowił sprawdzić, czy wprowadzenie płatnej mechaniki gry, w szczególności mechaniki automatu z gumą do żucia, może być lukratywną strategią monetyzacji. Oznaczałoby to sprzedaż mechanizmów, które inne gry zazwyczaj oferują za darmo. Tę unikalną płatną mechanikę wprowadzono na określonym zestawie poziomów, upewniając się, że nie zakłóci ona ogólnej równowagi rozgrywki.

Celem testu A/B było sprawdzenie, jak cenna była ta nowa mechanika dla graczy. Stworzono paywall, by zmierzyć reakcje użytkowników i określić, czy zakup został uznany za wartościowy. Głównym ryzykiem było to, że gracze mogliby zostać zniechęceni koniecznością płacenia za narzędzia, które wcześniej były darmowe.

Wyniki testu A/B pokazały, że najbardziej uproszczona mechanika odniosła największy sukces. Ten nieoczekiwany wynik podkreślił znaczenie testowania w aplikacjach mobilnych, pokazując, że czasami najmniej skomplikowane rozwiązania mogą przynieść najlepsze rezultaty.

5. Przykład testu A/B w e-mail marketingu

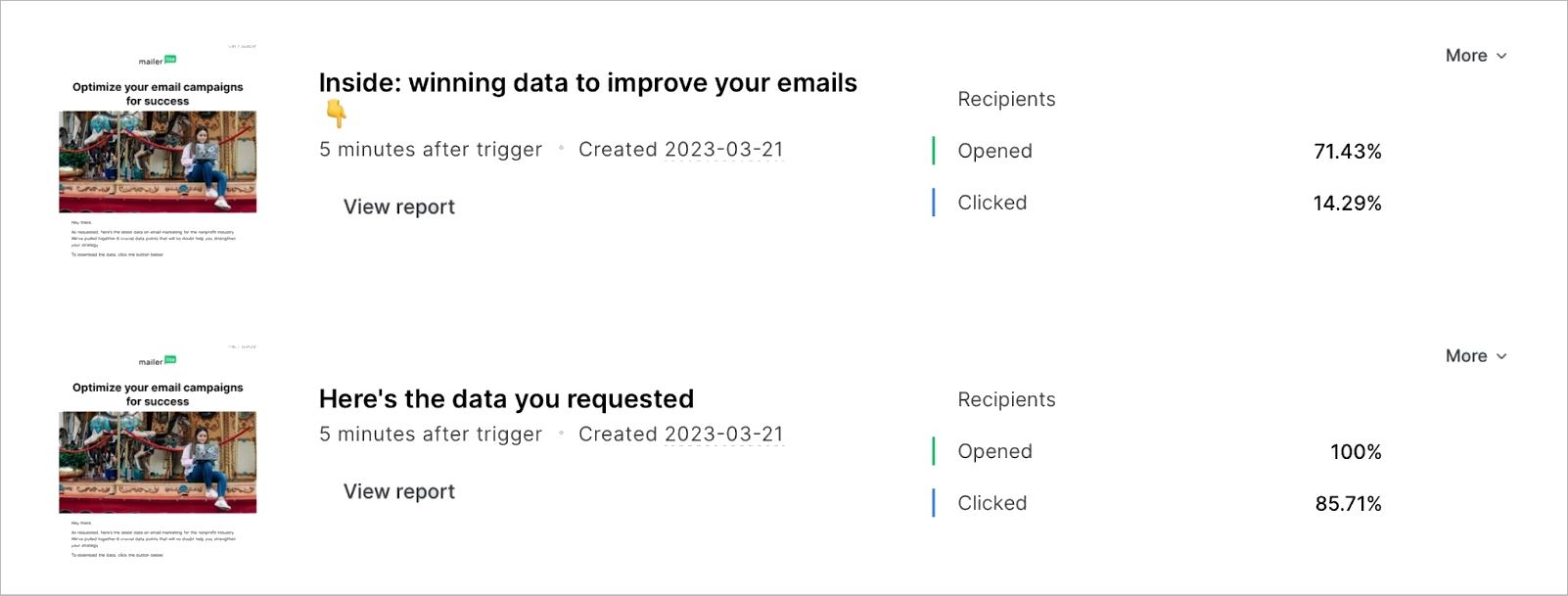

Ciekawe przykłady testów A/B pochodzą z MailerLite, a zostały opisane w artykule Jonasa Fischera “A/B testing email marketing examples to improve campaigns, landing pages and more”. Zespół MailerLite przeprowadził kilka testów A/B na przestrzeni lat, aby określić skuteczność używania emotikonów w tematach wiadomości e-mail, długości tematów, rozpoczynania tematu od pytania, pozycjonowania obrazów i GIF-ów oraz automatyzacji testów.

Dla lepszego zrozumienia testów A/B w email marketingu przyjrzyjmy się dwóm pierwszym opcjom. Gdy początkowo MailerLite testował emoji w tytułach, wyniki nie były zbyt obiecujące. W 2020 r. współczynnik otwarć dla tematu z emoji wynosił 31,82%, podczas gdy bez emoji – 31,93%. Jednak w miarę upływu czasu przeprowadzono więcej testów porównawczych i stwierdzano, że emoji w tematach wiadomości stały się bardziej atrakcyjne dla odbiorców. Ostatnie testy wykazały, że emoji mają znaczący korzystny wpływ na otwarcia. Współczynnik otwarć dla tytułu z emoji wyniósł 37,33%, w porównaniu do 36,87% dla tematu bez emoji.

Testowanie długości tematu również pokazało wpływ na zaangażowanie w wiadomości e-mail. MailerLite odkrył, że zwięzłe tematy były bardziej skuteczne w zachęcaniu subskrybentów do kliknięcia. Test wykazał, że krótsze tytuły mogą osiągnąć wynik 100% otwarć i 85,71% kliknięć.

6. Przykład testu A/B dla ecommerce

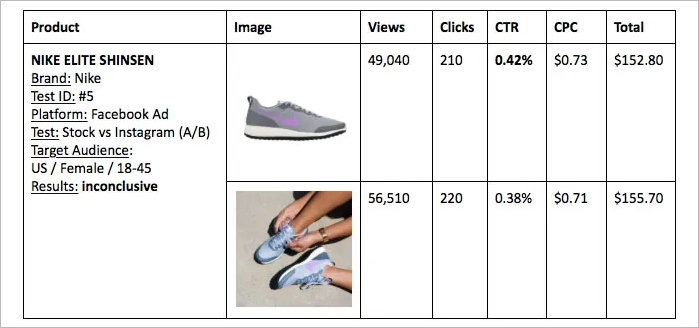

Tomer Dean, w artykule “The Battle of Conversion Rates – User Generated Content vs Stock Photos”, zbadał skuteczność treści generowanych przez użytkowników (UGC) w porównaniu ze zdjęciami stockowymi na rynku e-commerce. Obszerna kampania testów A/B dotyczyła w tym wypadku głównie mody i odzieży, porównując zdjęcia prawdziwych osób noszących produkty ze zdjęciami stockowymi.

W jednym z testów stockowe zdjęcie biustonosza sportowego Nike zostało zestawione ze zdjęciem zrobionym przez użytkownika na Instagramie. Wyniki były intrygujące, a obraz UGC osiągnął współczynnik konwersji na poziomie 0,90% w porównaniu do 0,31% zdjęcia stockowego. Podobne testy przeprowadzono dla innych produktów, takich jak spódnica Zara i buty do biegania Nike, z różnorodnymi wynikami. W innym eksperymencie dotyczącym czerwonych szpilek landing page wyświetlający zdjęcie stockowe wraz z trzema obrazami użytkowników znacznie prześcignął stronę z tylko zdjęciem stockowym.

Testy A/B podkreśliły potencjał UGC w zwiększaniu współczynników konwersji. W artykule podkreślono jednak również znaczenie ciągłego testowania i przestrzegania norm dotyczących praw autorskich podczas pozyskiwania materiałów wizualnych.

Fascynujące jest to, że witryny ecommerce generują średni przychód w wysokości 3 dolarów w przeliczeniu na unikalnego odwiedzającego, a udany test A/B pozwala zazwyczaj zwiększyć tę wartość nawet o 50% – zostało to zilustrowane w artykule Smriti Chawli “CRO Industry Insights from Our In-App Survey Results” dostępnym na stronie VWO.

Czy testy A/B można zastosować do każdego elementu na stronie internetowej?

Chociaż testy A/B można zastosować do każdego elementu na stronie, ważniejsze jest ustalenie priorytetów i skupienie się na tych komponentach, które mają znaczący wpływ na zachowanie użytkowników i współczynniki konwersji. Systematycznie testując i optymalizując kluczowe elementy, firmy mogą zmaksymalizować korzyści płynące z testów A/B i podejmować decyzje oparte na danych, które prowadzą do poprawy komfortu użytkowania i zwiększenia przychodów.

Czy istnieje ryzyko zrażenia użytkowników częstymi testami A/B?

Częste testy A/B mogą potencjalnie zrazić użytkowników, jeśli nie są starannie zaplanowane i przeprowadzane z myślą o doświadczeniu i preferencjach odbiorców. Ważne jest, aby znaleźć równowagę między testowaniem a utrzymaniem spójnego doświadczenia użytkownika.

Czym jest grupa kontrolna w testach A/B?

W testach A/B grupa kontrolna odnosi się do oryginalnej wersji strony internetowej lub aplikacji, która służy jako punkt odniesienia do porównania z wariantem. Grupa kontrolna służy jako baza do oceny wpływu zmian wprowadzonych w wersji testowej.

Co stanowi statystycznie istotny wynik w testach A/B?

Statystycznie istotne wyniki w testach A/B dają wysoki poziom pewności, że zaobserwowana różnica między grupą kontrolną a wariantem nie jest dziełem przypadku. Poziom istotności statystycznej jest zwykle ustalany na 95%, co oznacza, że istnieje tylko 5% szansy, że zaobserwowana różnica jest wynikiem losowości.

Jaki procent testów A/B/x kończy się niepowodzeniem?

Smriti Chawla z VWO w “CRO Industry Insights” podaje, że około 14% testów A/B kończy się statystycznie istotną wygraną, co oznacza, że 86% z nich nie poprawia współczynnika konwersji. Badania Convert.com przyniosły podobne wyniki dotyczące wpływu na konwersję. Jednak wskaźnik niepowodzeń może się różnić w zależności od branży i złożoności testu.

Jakie są popularne narzędzia używane w testach A/B?

Do popularnych narzędzi do testów A/B, które pomagają firmom zoptymalizować ich cyfrową obecność, należą m.in:

- Optimizely

- VWO

- Google Optimize

- Adobe Target

- AB Tasty

Narzędzia te oferują różne funkcje i możliwości, które ułatwiają firmom projektowanie, zarządzanie i analizowanie testów A/B.

Co ma większy wpływ na zachowanie użytkownika: zmiana koloru CTA czy jego tekstu?

Tekst CTA jest często bardziej istotny, ponieważ bezpośrednio komunikuje pożądane działanie. Jednak zarówno kolor, jak i treść mogą wpływać na zachowanie użytkowników. Według badania “The Button Color A/B Test: Red Beats Green” przeprowadzonego przez Joshuę Portera z Hubspot, zmiana koloru przycisku wezwania do działania może spowodować wzrost konwersji o 21%. Z drugiej strony, badanie Melanie Deziel “How to Build and Optimize CTA Buttons That Convert” sugeruje, że spersonalizowany tekst wezwania do działania może poprawić współczynniki konwersji nawet o 202%. O ile więc zmiana kolorystyki może sprawić, że przycisk CTA będzie bardziej atrakcyjny wizualnie, o tyle zmiana tekstu może znacząco wpłynąć na zachowanie użytkowników i prowadzić do wyższej konwersji.

Które branże odnoszą największe korzyści z testów A/B?

Branże, które odnoszą największe korzyści z testów A/B, obejmują:

- Ecommerce

- SaaS

- Marketing cyfrowy

- Aplikacje mobilne

Firmy z tych branż mogą znacznie poprawić swoją obecność w Internecie i osiągnąć stabilny wzrost, wdrażając testy porównawcze, które doprowadzą do optymalizacji doświadczeń użytkowników, poprawy współczynników konwersji i podejmowania decyzji opartych na danych.

Czym są testy A/B w marketingu?

Testy A/B w marketingu polegają na porównywaniu różnych strategii marketingowych, kreacji reklamowych lub komunikatów w celu ustalenia, które z nich przynoszą lepsze wyniki. Systematycznie sprawdzając różne warianty kampanii marketingowych, przedsiębiorstwa mogą określić, które podejścia rezonują z ich docelowymi odbiorcami i skutkują wyższym zaangażowaniem i konwersjami. Ponadto przeprowadzanie większej liczby testów pozwala na pełniejsze zrozumienie tego, co działa, a co nie, umożliwiając tym samym podejmowanie bardziej trafnych i skutecznych decyzji marketingowych.

Jaki jest przykład testów A/B w mediach społecznościowych?

Testy A/B w mediach społecznościowych polegają na porównywaniu różnych kreacji reklamowych, opcji targetowania lub formatów postów. Na przykład profil może przetestować dwa różne projekty graficzne dla reklamy na Facebooku wraz z różnymi opcjami targetowania, aby zidentyfikować, która kombinacja skutkuje wyższym zaangażowaniem i konwersjami.

Po co stosuje się testy A/B?

Testy A/B są stosowane, by ułatwić podejmowanie decyzji opartych na danych, zoptymalizować doświadczenia użytkowników i zwiększyć liczbę konwersji. Poprzez systematyczne badanie różnych wersji stron internetowych, aplikacji i kampanii marketingowych, marketerzy mogą dopracować swoje kampanie, zmaksymalizować zwrot z inwestycji i zapewnić sobie przewagę nad konkurencją.

Czy testy A/B są wskaźnikiem KPI?

Testy A/B można uznać za wskaźnik KPI, ponieważ pomagają mierzyć skuteczność zmian wprowadzanych w witrynie lub aplikacji oraz ich wpływ na zachowanie użytkowników i konwersje. Prowadząc regularne testy różnych wariantów i analizując ich wyniki, firmy mogą zidentyfikować najskuteczniejsze strategie i elementy, które napędzają konwersje.

Jaki jest przykład testów A/B poza internetem?

Testy A/B offline mogą dotyczyć sprawdzania różnych strategii cenowych, opakowań produktów lub układów sklepowych w celu zoptymalizowania sprzedaży i zadowolenia klientów. Porównując różne wersje tych zmiennych, firmy mogą określić, które zmiany w działaniach stacjonatnych prowadzą do wyższej sprzedaży i lepszej obsługi klienta.

Czym są próbki A/B?

Próbki A/B odnoszą się do dwóch wersji (kontrolnej i wariantowej) testowanej strony internetowej lub aplikacji. Porównując wydajność tych próbek, można określić, która wersja działa lepiej i zoptymalizować obecność w Internecie.

Ile firm korzysta z testów A/B?

Według badania CXL Institute “State of Conversion Optimization” z 2020 r. około 44% firm korzysta z oprogramowania do testów A/B. Badanie to zostało przeprowadzone wśród 333 firm różnej wielkości, od małych startupów po ogromne korporacje, z różnych branż.

Korzystanie z testów A/B jest bardziej powszechne wśród firm o silnej obecności online, takich jak ecommerce czy SaaS. Raport Econsultancy z 2019 r. dotyczący optymalizacji współczynnika konwersji ujawnił, że 77% firm, które mają ustrukturyzowane podejście do poprawy współczynników konwersji, wykorzystuje testy A/B.

W jaki sposób Netflix wykorzystuje testy A/B?

Netflix wykorzystuje testy A/B do poprawy doświadczeń użytkowników poprzez testowanie różnych interfejsów użytkownika, algorytmów rekomendacji, miniatur programów i filmów itp. Celem jest określenie, które warianty preferują konsumenci i które prowadzą do większego zaangażowania i dłuższego czasu oglądania.

Czy YouTube oferuje testy A/B?

YouTube nie udostępnia twórcom narzędzi do testów A/B. Sama platforma przeprowadza jednak testy A/B, aby zoptymalizować doświadczenia użytkowników i funkcje. Jeśli twórcy YouTube chcą testować swoje treści, muszą skorzystać z zewnętrznych narzędzi lub metod.

Czy Shopify oferuje testy A/B?

Shopify obsługuje testy A/B, ale nie ma wbudowanej funkcji do ich przeprowadzania. W sklepie Shopify dostępnych jest jednak kilka aplikacji innych firm, które umożliwiają przeprowadzanie testów.

Czy Mailchimp oferuje testy A/B?

Tak, Mailchimp oferuje funkcje testowania A/B. Pozwala użytkownikom eksperymentować z różnymi tematami, treściami i czasami wysyłania, aby zoptymalizować kampanie e-mailowe.

Czy w Wix można przeprowadzać testy A/B?

Wix nie ma wbudowanej funkcji testów A/B, ale narzędzia innych firm mogą być zintegrowane do testowania stron stworzonych w Wix. W ten sposób firmy korzystające z tej platformy mogą prowadzić testy A/B dla optymalizacji swoich witryn, poprawy komfortu użytkowania i zwiększenia współczynników konwersji.

Czy Google przeprowadza testy A/B?

Tak, Google często przeprowadza testy dzielone w celu oceny zmian i ulepszeń swoich produktów, usług i algorytmów. Pomaga to Google upewnić się, że wszelkie nowe funkcje lub zmiany zapewniają pozytywne wrażenia użytkownika i spełniają założenia.

Jak przeprowadzić testy A/B w Google Ads?

Aby przeprowadzić test A/B w Google Ads, wykonaj następujące cztery kroki:

- Zidentyfikuj element, który chcesz przetestować (tekst reklamy, landing page, słowa kluczowe itp.).

- Utwórz dwie wersje reklamy, jedną z oryginalnym elementem i jedną ze zmodyfikowanym.

- Uruchom obie reklamy jednocześnie na określony czas.

- Przeanalizuj dane dotyczące wydajności obu reklam, aby określić, która wersja przynosi lepsze wyniki.

Jak przeprowadzić test A/B w programie Excel?

Aby przeprowadzić test A/B w programie Excel, podziel dane na dwie grupy: A (grupa kontrolna) i B (grupa testowa). Oblicz średnią i odchylenie standardowe dla obu grup. Następnie użyj funkcji test-t programu Excel, aby porównać średnie i określić, czy istnieje statystycznie istotna różnica.

Ile danych potrzeba do przeprowadzenia testu A/B?

Czynniki, takie jak pożądany poziom istotności statystycznej, oczekiwana wielkość efektu i ruch na testowanej stronie lub aplikacji, wpływają na ilość danych potrzebnych do przeprowadzenia testu A/B. Aby test był bardziej wiarygodny, generalnie zaleca się większy rozmiar próby, przy czym niektórzy specjaliści z branży sugerują minimalny próg 100 konwersji na wariant.

Przy określaniu odpowiedniej ilości potrzebnych danych należy również wziąć pod uwagę konkretny kontekst i cele testu A/B.

Czy testy A/B są drogie?

Koszt testów A/B zależy od używanych narzędzi, złożoności testów i tego, czy przeprowadzasz je we własnym zakresie, czy zlecasz na zewnątrz. Niektóre narzędzia online oferują bezpłatne usługi podstawowe, podczas gdy inne mogą pobierać miesięczną opłatę.

Podsumowanie

Testy A/B to nie tylko narzędzie, ale sposób myślenia o ciągłym doskonaleniu i adaptacji. Umożliwiają one podejmowanie świadomych decyzji, popartych danymi, w celu doskonalenia strategii marketingowych i osiągnięcia optymalnych wyników. Niezależnie od tego, czy chodzi o ulepszenie przycisku CTA, eksperymentowanie z designem landing page’a, czy testowanie wariantów kampanii e-mailowych, testy A/B są nieocenionym zasobem w zestawie narzędzi marketera. W miarę jak zagłębiamy się w erę cyfrową, rola testów dzielonych w kształtowaniu doświadczeń użytkowników i napędzaniu sukcesu biznesowego staje się coraz ważniejsza.

Platformy takie jak Landingi rozpowszechniły dostęp do tego potężnego narzędzia, umożliwiając firmom każdej wielkości przeprowadzanie wnikliwych eksperymentów. Dzięki Landingi możesz stworzyć świetną kampanię i zoptymalizować ją za pomocą testów wielowariantowych, harmonogramu kampanii, dynamicznego zastępowania tekstu i opcji personalizacji, aby osiągnąć jak najlepsze wyniki. Najbardziej ekscytujące jest to, że możesz zacząć korzystać z platformy Landingi za darmo!