O sucesso no mundo digital de hoje depende da compreensão do comportamento do usuário e da otimização da experiência do usuário. Os testes A/B, também conhecidos como testes de divisão ou testes de balde, surgiram como uma peça fundamental nessa área. Plataformas de criação de páginas, como a Landingi, simplificaram o processo de teste de sites, tornando acessível para as empresas a realização desses experimentos perspicazes.

Este artigo abordará seis exemplos reais de testes A/B e estudos de caso que demonstram o poder transformador dos testes de divisão. Exploraremos como modificações aparentemente pequenas podem levar a melhorias significativas no desempenho da conversão. Também esclareceremos os resultados inesperados que podem surgir desses experimentos, provando que, às vezes, as mudanças mais surpreendentes podem gerar os resultados mais eficazes. Também discutiremos as armadilhas comuns nos testes de balde, incluindo processos apressados, desconsideração da significância estatística e mudanças baseadas em resultados inconclusivos.

Junte-se a nós enquanto navegamos pelo mundo dos testes A/B e descobrimos seu potencial para otimizar as taxas de conversão e aprimorar a experiência do usuário.

O que é teste A/B?

O teste A/B é um método que ajuda a tomar decisões orientadas por dados, comparando diferentes versões de uma página da Web ou de um aplicativo para determinar qual tem melhor desempenho. Geralmente, envolve o teste de várias variantes de página (teste A/B/x) para otimizar a experiência do usuário e as taxas de conversão.

No artigo de Adelina Karpenkova intitulado “A/B Testing in Marketing: The Best Practices Revealed” (As melhores práticas reveladas), afirma-se que o teste é um componente integral do processo de otimização da taxa de conversão (CRO). A definição de teste A /B indica a investigação das respostas de públicos semelhantes a duas versões de conteúdo idêntico, em que a única diferença está em uma única variável.

De acordo com o artigo da CXL “5 Things We Learned from Analyzing 28,304 Experiments” (5 coisas que aprendemos com a análise de 28.304 experimentos), de Dennis van der Heijden, esse tipo de experimento é o teste preferido da maioria dos otimizadores, com testes A/B totalizando 97,5% de todos os experimentos em sua plataforma. Os testes de divisão ganharam popularidade devido ao seu potencial de sucesso repetível, aumento de receita e otimização da taxa de conversão.

Portanto, pense nesses testes como uma superpotência de marketing que otimiza as campanhas para obter o máximo impacto.

Onde o teste A/B é usado?

Os aplicativos de teste A/B abrangem vários setores, provando ser um divisor de águas em setores como o de

- comércio eletrônico

- SaaS

- publicação

- aplicativos móveis

- marketing por e-mail

- mídia social

A criação de uma nova versão de uma página existente e a comparação de seu desempenho com a original permitem que as empresas aumentem as taxas de conversão e otimizem sua presença digital com base no comportamento e nas preferências reais do usuário. Isso pode ser particularmente útil ao gerenciar várias páginas em um site.

Quais são as vantagens do teste A/B?

As vantagens dos testes A/B permitem que você elimine as suposições, tome decisões com base em evidências concretas, otimize sua presença on-line e, por fim, obtenha melhores resultados. Os benefícios dos testes divididos podem ser agrupados em 10 categorias, que são as seguintes:

- Melhoria da experiência do usuário (UX): Ao testar diferentes variações do seu conteúdo, design ou recursos, é possível identificar qual versão proporciona uma melhor experiência ao usuário, o que leva a uma maior satisfação do usuário.

- Decisões orientadas por dados: Os testes A/B fornecem dados concretos sobre o que funciona melhor para o seu público, eliminando a necessidade de confiar em intuições ou suposições. Isso permite a tomada de decisões mais informadas.

- Aumento das taxas de conversão: Ao identificar qual versão de uma página da Web ou recurso leva a melhores taxas de conversão, você pode otimizar seus sites para gerar mais vendas, inscrições ou qualquer outra ação desejada.

- Redução das taxas de rejeição: Se os usuários acharem seu conteúdo ou layout mais envolvente ou mais fácil de navegar, é menos provável que saiam do site rapidamente, reduzindo a taxa de rejeição. Por exemplo, você pode descobrir que os usuários de dispositivos móveis preferem um layout ou uma apresentação de conteúdo diferente, o que leva a uma redução nas taxas de rejeição em dispositivos móveis.

- Custo-benefício: Muitos exemplos de testes A/B demonstram como a realização desses testes pode evitar erros dispendiosos. Ao testar as alterações antes de implementá-las totalmente, as empresas podem evitar investir em recursos ou designs que não repercutem em seu público.

- Redução de riscos: O lançamento de grandes mudanças sem testes pode ser arriscado. Os testes A/B permitem que você teste primeiro as alterações em um público menor, reduzindo o possível impacto negativo de uma implementação em grande escala.

- Maior envolvimento com o conteúdo: Testar diferentes títulos, imagens ou layouts de conteúdo pode ajudar a identificar o que mantém os usuários envolvidos por períodos mais longos.

- Melhor ROI: Para as empresas que gastam dinheiro em campanhas de publicidade ou marketing, os testes A/B podem garantir que as páginas de destino sejam otimizadas para conversão, levando a um melhor retorno sobre o investimento.

- Entender as preferências do público: Com o tempo, os testes A/B consistentes podem fornecer insights sobre as preferências e os comportamentos do público, permitindo estratégias de marketing e conteúdo mais bem direcionadas.

- Melhoria contínua: Os testes de divisão promovem uma cultura de melhoria contínua em que as empresas estão sempre procurando maneiras de otimizar e aprimorar sua presença on-line.

O relatório da CXL “State of Conversion Optimization 2020” indica que o teste A/B é a segunda melhor estratégia de otimização de conversão. Além disso, como Smriti Chawla aponta no relatório “CRO Industry Insights from Our In-App Survey Results” da VWO, foi demonstrado que testes estatisticamente significativos aumentam as taxas de conversão em uma média de 49%.

Dito isso, é evidente que hipóteses claras e testes de balde bem executados podem liberar todo o potencial do seu site ou aplicativo e maximizar o retorno sobre o investimento.

Quais são as desvantagens do teste A/B?

A principal desvantagem do teste A/B está na possibilidade de alienar os usuários se os testes forem realizados com muita frequência ou sem a devida preparação. Testes inadequados podem fazer com que os usuários se deparem com experiências inconsistentes, o que pode causar insatisfação.

Além disso, as armadilhas comuns em testes multivariados incluem processos apressados, desconsideração da significância estatística e mudanças baseadas em resultados de testes inconclusivos. Processos apressados podem levar a testes mal projetados, enquanto a desconsideração da significância estatística pode resultar em decisões baseadas no acaso e não no efeito real. Além disso, fazer alterações com base em resultados inconclusivos pode causar confusão e levar a dados enganosos.

Você deve reservar um tempo adequado para cada teste, garantir um tamanho de amostra suficiente para a significância estatística e abster-se de fazer alterações até que os resultados sejam conclusivos e estatisticamente significativos.

Elementos comuns testados em testes A/B

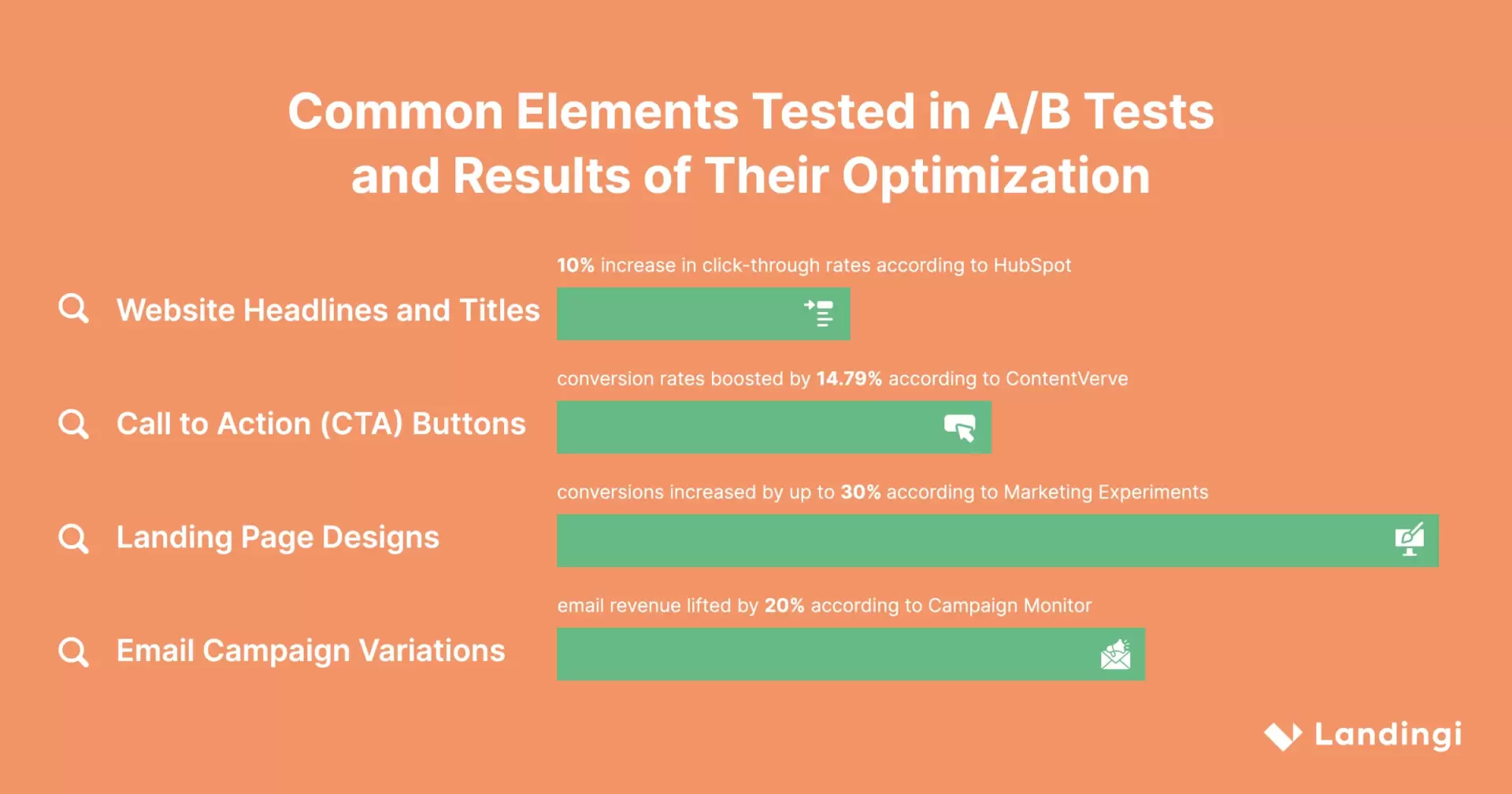

Os elementos mais comuns testados em testes A/B incluem:

- Manchetes e títulos

- Botões de CTA (chamada para ação)

- Projetos de páginas de destino

- Variações da campanha de e-mail

Há também muitos exemplos de experiências com formulários de inscrição, seções de prova social e textos de anúncios. A chave para um teste multivariado bem-sucedido é concentrar-se nos elementos que têm o impacto mais significativo sobre o comportamento do usuário e a taxa de conversão.

Vamos explorar os elementos mais populares em mais detalhes.

Títulos e cabeçalhos de sites

Um título cativante pode fazer toda a diferença para atrair e reter os visitantes do site. Os testes A/B permitem que você faça experiências com diferentes cabeçalhos e títulos para identificar quais deles repercutem melhor no seu público-alvo. Ao modificar fatores como redação, mensagem e estilo, você pode otimizar seu texto para obter taxas de cliques mais altas, maior envolvimento e melhor desempenho do site.

De acordo com a Hubspot, fazer experiências com manchetes e títulos pode aumentar as taxas de cliques em até 10%.

Botões de chamada para ação (CTA)

Os botões de CTA desempenham um papel crucial na geração de conversões. Os testes A/B permitem que você compare diferentes versões de botões de CTA para identificar qual delas produz melhores resultados em termos de taxas de conversão. Ao alterar o design, a cor, o tamanho, o texto ou a posição dos botões, você pode influenciar o comportamento do usuário e aumentar a eficácia da sua chamada para ação.

A ConvertVerve comprovou que os testes de divisão de botões aumentam as taxas de conversão em 14,79%.

Designs de páginas de destino

Uma página de destino bem projetada pode melhorar significativamente a experiência do usuário e as taxas de conversão. Nos testes multivariados, os recursos comumente modificados incluem:

- Layout da página

- Manchetes

- Subtítulos

- Texto do corpo

- Preços

- Botões

- Fluxo de registro

- Comprimento do formulário

- Elementos gráficos

Experimentar diferentes variações de páginas de destino é fundamental para otimizar a qualidade dos leads e as taxas de conversão. Ao testar vários designs, você pode identificar quais elementos repercutem no seu público-alvo e impulsionam as ações desejadas, e quais podem estar causando atrito ou confusão. Esse processo de aprimoramento contínuo pode melhorar significativamente o desempenho geral de uma página de destino.

As experiências de marketing mostraram que a otimização do design da página de destino aumenta as conversões em até 30%.

O Landingi, um renomado construtor de páginas de destino, oferece uma infinidade de recursos que atendem a essa necessidade. Com sua interface intuitiva e recursos robustos de teste, o Landingi facilita a criação, duplicação, modificação, teste e otimização de páginas de destino.

Use as Smart Sections para trabalhar de forma inteligente em várias landing pages ao mesmo tempo e esqueça as tediosas revisões manuais! Uma maneira simples de gerenciar alterações em massa.

Variações de campanhas de e-mail

As campanhas de e-mail são uma poderosa ferramenta de marketing, e os testes A/B podem ajudá-lo a otimizar suas campanhas para obter o máximo impacto. Ao criar e comparar várias versões de suas mensagens, você pode identificar quais variações repercutem melhor no seu público-alvo e levam a taxas de abertura e de cliques mais altas.

O teste A/B é uma ferramenta inestimável que permite refinar sua estratégia de marketing por e-mail com base no comportamento e nas preferências reais do usuário.

Por exemplo, considere uma empresa que vende joias feitas à mão on-line. Ela poderia usar o teste A/B para descobrir a linha de assunto mais eficaz do boletim informativo por e-mail. Eles criam duas versões do mesmo e-mail, diferindo apenas na linha de assunto. Um e-mail pode ter a linha de assunto “Nova coleção: Joias feitas à mão só para você” e o outro “Descubra sua nova peça favorita”. Ao enviar esses e-mails para diferentes subconjuntos de seu público, eles podem rastrear qual e-mail tem uma taxa de abertura mais alta. A linha de assunto mais bem-sucedida é então usada em futuros boletins informativos, o que pode levar a um maior envolvimento e vendas.

De acordo com o Campaign Monitor, as variações de campanhas de e-mail podem aumentar a receita de e-mail em 20%.

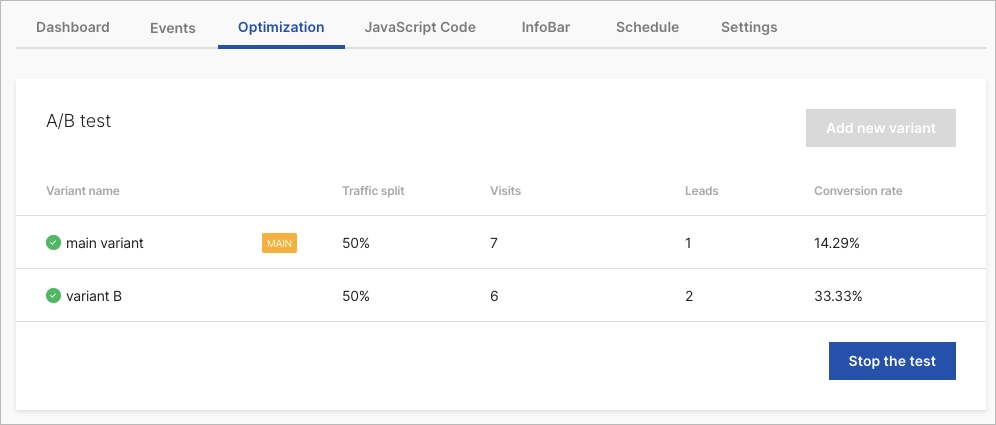

1. Exemplo de teste A/B de página de destino

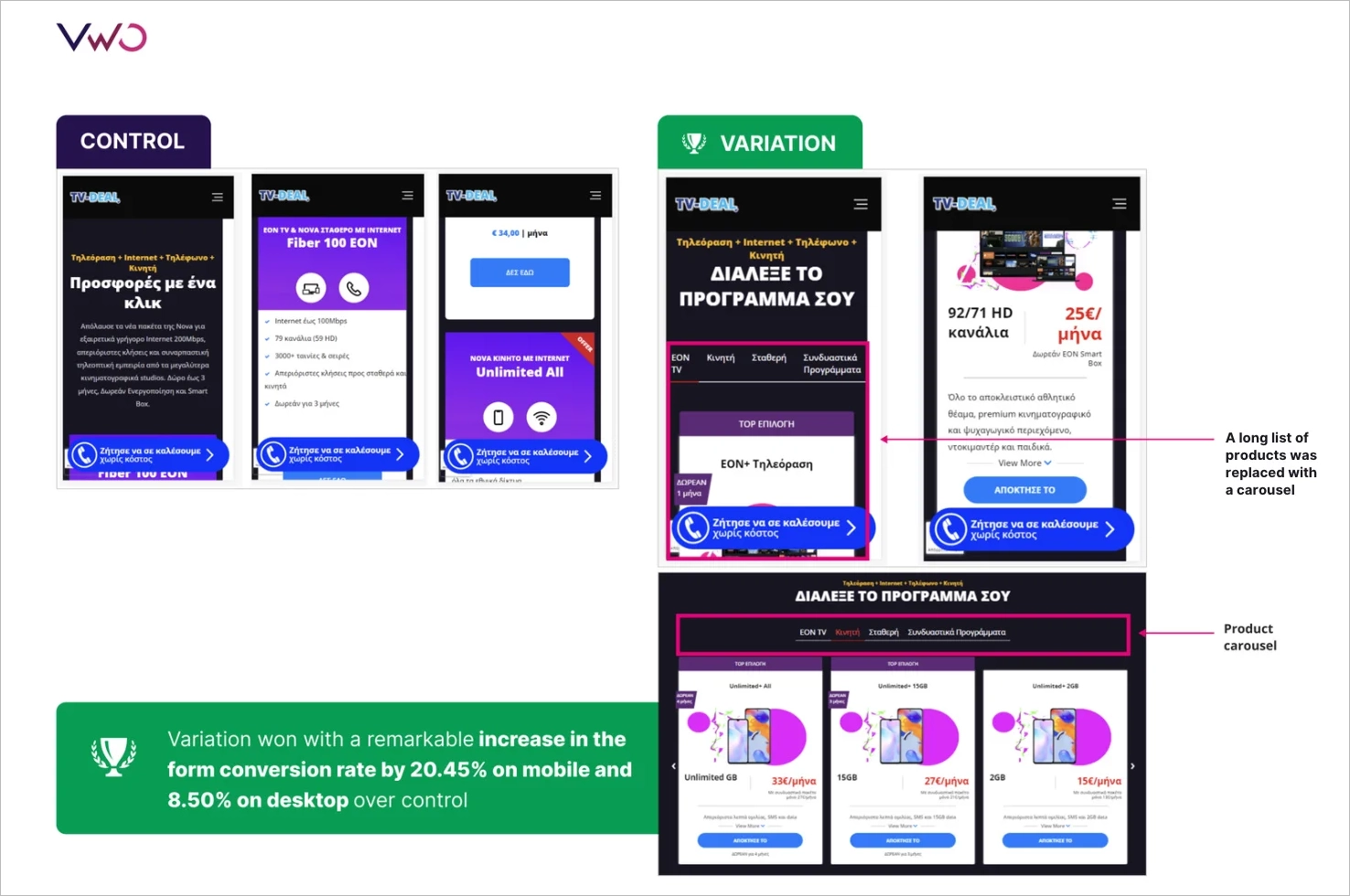

O primeiro de nossos exemplos de teste A/B envolve naturalmente uma página de destino, já que os profissionais de marketing testam regularmente esse tipo de site. A ForestView, uma agência sediada em Atenas, Grécia, embarcou em uma ampla campanha de testes A/B para otimizar a página de destino de seu cliente.

A equipe da Forestview levantou a hipótese de que a redução da quantidade de rolagem necessária ajudaria os usuários a encontrar seu produto preferido com mais facilidade, levando a melhores taxas de conversão para o formulário. Para testar essa hipótese, eles realizaram um teste A/B com uma página de destino reformulada. O novo design incluía filtros de vários níveis para permitir que os usuários encontrassem seu produto preferido dinamicamente e substituiu uma longa lista de produtos por carrosséis.

O teste A/B foi executado por 14 dias, com mais de 5.000 visitantes divididos igualmente entre os grupos de controle e de variação. Os resultados mostraram que a variação superou o controle, com a filtragem multinível e o design de carrossel aumentando a taxa de conversão do formulário em 20,45% no celular e 8,50% no desktop. Além disso, o envolvimento do usuário aumentou em 70,92%.

2. Exemplo de teste A/B de SaaS

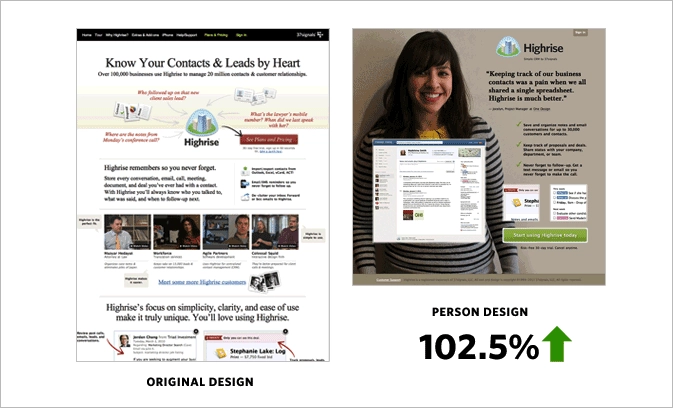

No setor de SaaS, os testes A/B se destacam por seu poder de transformação na otimização dos designs de sites. Um artigo do Signal v. Noise da Basecamp fornece insights sobre as vantagens concretas dos testes divididos no site de marketing da Highrise.

A equipe tinha a hipótese de que um design conciso, denominado “Página pessoal”, atrairia mais os usuários e resultaria em taxas de conversão mais altas. Para testar sua teoria, eles realizaram um teste A/B que comparou a “Página pessoal” com o design do “Formulário longo”. Os resultados mostraram que a “Person Page” teve um aumento de 47% nas inscrições pagas (102,5% de aumento em comparação com o design original). Entretanto, quando foram adicionadas informações extras ao design, sua eficácia caiu 22%.

Em outro experimento, a equipe analisou o impacto das fotos dos clientes nas conversões. Eles descobriram que imagens grandes e alegres de clientes aumentavam as conversões, mas a pessoa específica apresentada na foto não importava.

A equipe passou várias semanas realizando testes A/B, analisando cuidadosamente o comportamento e as preferências dos usuários. A principal conclusão de seus experimentos foi que o teste de balde é uma ferramenta valiosa que pode desmistificar suposições e revelar elementos de design que realmente repercutem nos usuários.

3. Exemplo de teste A/B em imóveis

O setor imobiliário, como muitos outros, depende muito da eficácia de suas plataformas digitais. Gigantes do setor imobiliário, como Zillow, Trulia e StreetEasy, entendem a importância de refinar continuamente a experiência do usuário para atender às necessidades do público. Eles conseguem isso realizando testes A/B, conforme descrito no artigo da Anadea “How Effective A/B Testing Helps to Build a Cool Real Estate App”.

A StreetEasy, uma plataforma imobiliária sediada na cidade de Nova York, reconheceu as preferências exclusivas de seu público. Eles realizaram um teste A/B para determinar os filtros de pesquisa mais eficazes para seus usuários e descobriram que eles preferiam pesquisar por bairros e tipos de edifícios. Em Nova York, a localização de um apartamento e o tipo de edifício em que ele se encontra podem influenciar significativamente a decisão de um possível comprador ou locatário. Por exemplo, uma pessoa acostumada a morar em Tribeca pode não estar interessada em um apartamento em Chinatown, mesmo que ele atenda a todos os outros critérios.

Além dos filtros de pesquisa, a representação visual das listagens também é crucial para os possíveis compradores. Os visitantes passam aproximadamente 60% do tempo olhando as fotos dos anúncios, o que torna o tamanho dessas imagens um fator significativo para o envolvimento do usuário e as taxas de conversão.

Além disso, a descrição que acompanha um anúncio pode influenciar a decisão de um possível comprador. A Zillow realizou um estudo que analisou 24.000 vendas de casas e descobriu que determinadas palavras nas descrições dos anúncios faziam com que as casas fossem vendidas por preços mais altos do que o esperado. Descobriu-se que palavras como “luxuoso”, “paisagismo” e “atualizado” aumentavam as taxas de conversão.

Get 111 Landing Page Examples—The Ultimate Guide for FREE

4. Exemplo de teste A/B de aplicativo móvel

O quarto de nossos exemplos de testes A/B envolve um aplicativo móvel, dada a tendência crescente de otimização de aplicativos móveis. A AppQuantum e a Red Machine colaboraram em uma extensa campanha de testes A/B para o aplicativo Doorman Story, que é um jogo de simulação de gerenciamento de tempo em que os jogadores gerenciam seu próprio hotel. O exemplo foi descrito no artigo “How to Conduct A/B Tests in Mobile Apps: Parte I”, publicado no site do Medium.

A equipe da AppQuantum decidiu testar se a introdução de uma mecânica de jogo paga, especificamente uma máquina de chicletes, poderia ser uma estratégia de monetização lucrativa. Isso significaria vender uma mecânica de jogo existente que outros jogos normalmente oferecem gratuitamente. Eles introduziram essa mecânica de jogo paga exclusiva em um conjunto específico de níveis, certificando-se de que ela não atrapalhasse o equilíbrio geral do jogo.

O objetivo do teste A/B era avaliar o valor dessa nova mecânica para os jogadores. Eles introduziram um acesso pago para medir as reações dos usuários e determinar se a compra era considerada valiosa. No entanto, o principal risco era que os jogadores pudessem ser dissuadidos por terem de pagar por ferramentas que antes eram gratuitas.

Depois de realizar o teste A/B, os resultados mostraram que a mecânica mais simplificada foi a mais bem-sucedida. Esse resultado inesperado enfatizou a importância dos testes A/B em aplicativos móveis, mostrando que, às vezes, as soluções mais simples podem gerar os melhores resultados.

5. Exemplo de teste A/B de marketing por e-mail

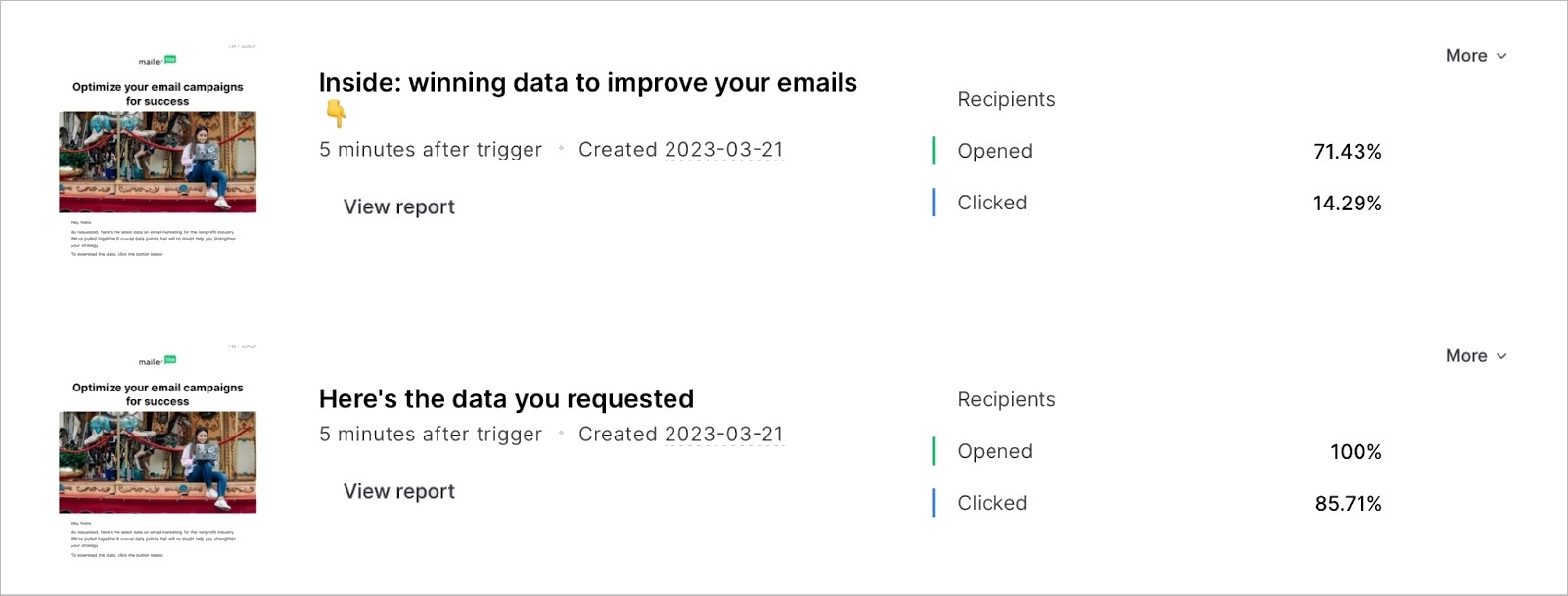

Exemplos intrigantes de testes A/B vêm do MailerLite, descritos no artigo de Jonas Fischer “A/B testing email marketing examples to improve campaigns, landing pages and more”. A equipe do MailerLite realizou vários testes A/B ao longo dos anos para determinar a eficácia do uso de emojis em linhas de assunto de e-mail, o tamanho das linhas de assunto, iniciar a linha de assunto com uma pergunta, o posicionamento de imagens e GIFs e a automação de testes.

Vamos examinar as duas primeiras opções para obter insights mais profundos sobre os testes A/B de marketing por e-mail. Inicialmente, a equipe do MailerLite testou emojis em suas linhas de assunto, e os resultados não foram muito promissores. Em 2020, a taxa de abertura de uma linha de assunto com emojis foi de 31,82%, enquanto sem emojis foi de 31,93%. No entanto, com o passar do tempo, eles realizaram mais testes de divisão A/B e descobriram consistentemente que os emojis na linha de assunto eram mais eficazes para seu público. Testes recentes mostraram que os emojis na linha de assunto têm um impacto positivo significativo nas taxas de abertura. A taxa de abertura de um assunto com emojis foi de 37,33%, em comparação com 36,87% sem emojis.

Testar o comprimento da linha de assunto também mostrou que ele pode influenciar o envolvimento do e-mail. O MailerLite descobriu que linhas de assunto concisas eram mais eficazes para gerar cliques para seus assinantes. O teste mostrou que assuntos mais curtos podem atingir uma taxa de abertura de 100% e uma taxa de cliques de 85,71%.

6. Exemplo de teste A/B de comércio eletrônico

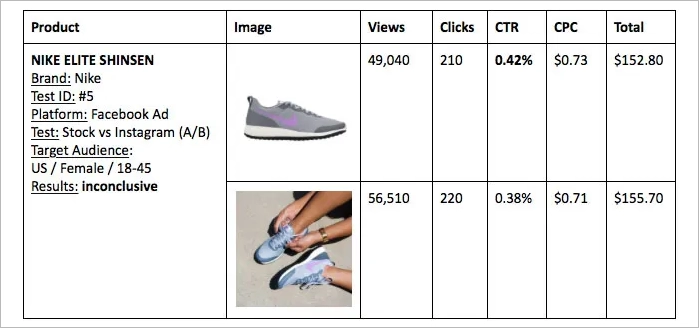

O artigo intitulado “The Battle of Conversion Rates – User Generated Content vs Stock Photos” (A Batalha das Taxas de Conversão – Conteúdo Gerado pelo Usuário vs. Fotos de Bancos de Imagens), de Tomer Dean, analisou a eficácia do conteúdo gerado pelo usuário (UGC) em comparação com as fotos de bancos de imagens no âmbito do comércio eletrônico. Uma extensa campanha de testes A/B girou principalmente em torno de itens de moda e vestuário, comparando imagens de pessoas reais usando produtos com fotos de estoque tiradas profissionalmente.

Em um dos testes, a imagem de estoque de um sutiã esportivo da Nike foi comparada a uma imagem gerada pelo usuário no Instagram. Os resultados foram intrigantes, com a imagem UGC atingindo uma taxa de conversão de 0,90% em comparação com os 0,31% da foto de estoque. Testes semelhantes foram realizados para outros produtos, como uma saia da Zara e tênis de corrida da Nike, com resultados variados. Em outro experimento envolvendo saltos altos vermelhos, uma página de destino que exibia a imagem de estoque juntamente com três imagens de UGC superou significativamente a página com apenas a imagem de estoque.

Os testes A/B ressaltaram o potencial do UGC no aumento das taxas de conversão. No entanto, o artigo também enfatizou a importância de testes contínuos e da adesão às normas de direitos autorais ao obter imagens.

O que é ainda mais fascinante é que os sites de comércio eletrônico geram uma receita média de US$ 3 por visitante único, e um teste A/B bem-sucedido normalmente aumenta esse valor em até 50%, conforme ilustrado no artigo de Smriti Chawla “CRO Industry Insights from Our In-App Survey Results” no site da VWO.

Os testes A/B podem ser aplicados a todos os elementos de um site?

Embora o teste A/B possa ser aplicado a qualquer elemento de um site, o mais importante é priorizar e concentrar-se nos elementos que afetam significativamente o comportamento do usuário e as taxas de conversão. Ao testar e otimizar sistematicamente os principais elementos, as empresas podem maximizar os benefícios dos testes A/B e tomar decisões orientadas por dados que levam a uma melhor experiência do usuário e a um aumento das receitas.

Existe o risco de alienar os usuários com testes A/B frequentes?

Se não forem planejados e executados com cuidado, tendo em mente a experiência e as preferências do usuário, os testes A/B frequentes podem alienar os usuários. É importante encontrar um equilíbrio entre os testes e a manutenção de uma experiência de usuário consistente.

O que é um grupo de controle no teste A/B?

No teste A/B, um grupo de controle refere-se à versão original de uma página da Web ou aplicativo, que serve como linha de base para comparação com a variação. O grupo de controle serve como ponto de referência para avaliar o impacto das alterações feitas na versão de teste.

O que constitui um resultado estatisticamente significativo em testes A/B?

Resultados estatisticamente significativos em testes A/B indicam um alto nível de confiança de que a diferença observada entre o controle e a variação não se deve ao acaso. O nível de significância estatística é normalmente definido em 95%, o que significa que há apenas 5% de chance de que a diferença observada se deva à aleatoriedade.

Qual a porcentagem de falhas nos testes A/B/x?

De acordo com o CRO Industry Insights de Smriti Chawla da VWO, cerca de 14% dos testes A/B são testes vencedores estatisticamente significativos, o que significa que 86% não conseguem melhorar as taxas de conversão. A pesquisa da Convert.com produziu resultados semelhantes sobre o impacto na conversão. Entretanto, a taxa de falha pode variar dependendo do setor e da complexidade do teste.

Quais são as ferramentas populares usadas em testes A/B?

Há várias ferramentas populares de teste A/B disponíveis para ajudar as empresas a otimizar sua presença digital, como:

- Optimizely

- VWO

- Otimização do Google

- Alvo da Adobe

- AB Tasty

Essas ferramentas oferecem vários recursos e funcionalidades que permitem às empresas projetar, gerenciar e analisar testes A/B de forma eficaz.

O que tem um impacto mais profundo no comportamento do usuário: mudar a cor da CTA ou seu texto?

O texto da CTA geralmente é mais importante, pois comunica diretamente a ação desejada. No entanto, tanto a cor quanto o texto podem afetar o comportamento do usuário. De acordo com um estudo, “The Button Color A/B Test: Red Beats Green” realizado por Joshua Porter da Hubspot, alterar a cor de um botão de call-to-action pode resultar em um aumento de 21% nas conversões. Por outro lado, a pesquisa de Melanie Deziel, “How to Build and Optimize CTA Buttons That Convert” (Como criar e otimizar botões de CTA que convertem), sugere que o texto personalizado da frase de chamariz pode melhorar as taxas de conversão em até 202%. Dito isso, embora a alteração da paleta de cores possa tornar o botão de CTA mais atraente visualmente, a alteração do texto pode afetar significativamente o comportamento do usuário e levar a conversões mais altas.

Quais setores se beneficiam mais com os testes A/B?

Os setores que mais se beneficiam dos testes A/B incluem:

- Comércio eletrônico

- SaaS

- Marketing digital

- Desenvolvimento de aplicativos móveis

As empresas desses setores podem melhorar significativamente sua presença digital e alcançar o crescimento implementando testes divididos para otimizar a experiência do usuário, melhorar as taxas de conversão e permitir decisões orientadas por dados.

O que é o teste A/B no exemplo do marketing?

O teste A/B em marketing envolve a comparação de diferentes estratégias de marketing, criativos de anúncios ou mensagens para determinar qual delas gera melhores resultados. Ao testar sistematicamente diferentes variações de campanhas de marketing, as empresas podem identificar quais abordagens repercutem em seu público-alvo e resultam em maior envolvimento e conversões. Além disso, a execução de mais testes permite uma compreensão mais abrangente do que funciona e do que não funciona, possibilitando, assim, decisões de marketing mais precisas e eficazes.

Qual é um exemplo de teste A/B na mídia social?

Os testes A/B em mídias sociais consistem em comparar diferentes criativos de anúncios, opções de segmentação ou formatos de posts. Por exemplo, uma empresa poderia testar duas imagens diferentes para um anúncio no Facebook, juntamente com diferentes opções de segmentação, para identificar qual combinação resulta em maior engajamento e conversões.

Por que usamos o teste A/B?

Os testes A/B são usados para facilitar as decisões baseadas em dados, otimizar a experiência do usuário e aumentar as taxas de conversão. Ao testar sistematicamente diferentes variações de páginas da Web, aplicativos e campanhas de marketing, os profissionais de marketing podem ajustar suas campanhas, maximizar o retorno sobre o investimento e garantir que fiquem à frente da concorrência e obtenham crescimento.

O teste A/B é um KPI?

O teste A/B pode ser considerado um KPI, pois ajuda a medir a eficácia das alterações feitas em um site ou aplicativo e seu impacto no comportamento do usuário e nas conversões. Ao testar sistematicamente diferentes variações e analisar os resultados, as empresas podem identificar as estratégias e os elementos mais eficazes que geram conversões.

Qual é um exemplo de teste A/B na vida real?

Exemplos reais de testes A/B incluem testar diferentes estratégias de preços, embalagens de produtos ou layouts de lojas para otimizar as vendas e a satisfação do cliente. Ao comparar diferentes versões dessas variáveis, as empresas podem identificar quais alterações levam a um aumento nas vendas e a uma melhor experiência do cliente.

O que são amostras A/B?

As amostras A/B referem-se às duas versões (controle e variação) de uma página da Web ou aplicativo que está sendo testado. Ao comparar o desempenho dessas amostras, você pode identificar qual versão tem melhor desempenho e otimizar sua presença digital.

Quantas empresas usam testes A/B?

De acordo com uma pesquisa do CXL Institute de 2020, “State of Conversion Optimization”, aproximadamente 44% das empresas empregam software de teste A/B. Essa pesquisa foi realizada com 333 empresas de vários tamanhos, desde pequenas startups até grandes corporações, em uma série de setores.

O uso de testes A/B é mais predominante entre empresas com forte presença on-line, como empresas de comércio eletrônico e SaaS. Por exemplo, um Relatório de Otimização da Taxa de Conversão da Econsultancy de 2019 revelou que 77% das empresas que têm uma abordagem estruturada para melhorar as taxas de conversão usam testes A/B até certo ponto.

Como a Netflix usa os testes A/B?

A Netflix usa testes A/B para melhorar a experiência do usuário, testando diferentes interfaces de usuário, algoritmos de recomendação, miniaturas de programas e filmes e muito mais. O objetivo é determinar quais variações os usuários preferem e quais levam a um maior envolvimento e a tempos de exibição mais longos.

O YouTube tem testes A/B?

O YouTube não fornece ferramentas de teste A/B para criadores. No entanto, o próprio YouTube realiza testes A/B em sua plataforma para otimizar a experiência e os recursos do usuário. Se os criadores quiserem realizar testes A/B em seu conteúdo, eles precisarão usar ferramentas ou métodos externos.

A Shopify tem testes A/B?

A Shopify é compatível com testes A/B, mas não tem um recurso integrado para isso. No entanto, há vários aplicativos de terceiros disponíveis na loja de aplicativos da Shopify que permitem a execução de testes.

O Mailchimp pode fazer testes A/B?

Sim, o Mailchimp oferece recursos de teste A/B. Ele permite que os usuários testem diferentes linhas de assunto, conteúdo e horários de envio para otimizar as campanhas de e-mail.

O Wix pode fazer testes A/B?

O Wix não tem um recurso de teste A/B incorporado, mas ferramentas de terceiros, como o Google Optimize, podem ser integradas para testes A/B em sites do Wix. As empresas que usam o Wix podem realizar testes A/B para otimizar seus sites, aprimorar a experiência do usuário e aumentar as taxas de conversão, aproveitando essas ferramentas.

O Google faz testes A/B?

Sim, o Google realiza testes de divisão com frequência para avaliar alterações e melhorias em seus produtos, serviços e algoritmos. Isso ajuda o Google a garantir que quaisquer novos recursos ou alterações proporcionem uma experiência positiva ao usuário e atendam aos objetivos pretendidos.

Como fazer testes A/B com o Google Ads?

Para realizar testes A/B com o Google Ads, siga estas quatro etapas:

- Identifique o elemento que deseja testar (texto do anúncio, página de destino, palavras-chave, etc.).

- Crie duas versões de seu anúncio, uma com o elemento original e outra com o elemento modificado.

- Execute os dois anúncios simultaneamente por um período definido.

- Analise os dados de desempenho de ambos os anúncios para determinar qual versão oferece melhores resultados.

Como realizar um teste A/B no Excel?

Você pode realizar um teste A/B no Excel organizando seus dados em dois grupos: A (controle) e B (teste). Calcule a média e o desvio padrão para ambos os grupos. Em seguida, use a função de teste t do Excel para comparar as médias dos dois grupos e determinar se há uma diferença estatisticamente significativa.

Quantos dados são necessários para o teste A/B?

Fatores como o nível desejado de significância estatística, o tamanho do efeito esperado e o tráfego para a página ou aplicativo testado influenciam a quantidade de dados necessários para um teste A/B. Um tamanho de amostra maior é geralmente recomendado para um teste mais confiável, com alguns especialistas do setor sugerindo um tamanho mínimo de amostra de 100 conversões por variação.

O contexto e as metas específicas do teste A/B também devem ser levados em conta ao determinar a quantidade adequada de dados necessários.

Os testes A/B são caros?

O custo do teste A/B depende das ferramentas que você usa, da complexidade dos testes e do fato de você estar realizando-os internamente ou terceirizando-os. Algumas ferramentas on-line oferecem serviços básicos gratuitos, enquanto outras podem cobrar uma taxa mensal.

Conclusão

O teste A/B não é apenas uma ferramenta, mas uma mentalidade de aprimoramento e adaptação contínuos. Ele permite que os profissionais de marketing tomem decisões informadas, com base em dados, para refinar suas estratégias e obter os melhores resultados. Seja ajustando um botão de CTA, experimentando designs de páginas de destino ou testando variações de campanhas de e-mail, o teste A/B é um recurso inestimável no kit de ferramentas do profissional de marketing. À medida que nos aprofundamos na era digital, o papel dos testes A/B na modelagem das experiências do usuário e na promoção do sucesso dos negócios torna-se cada vez mais importante.

Plataformas como a Landingi democratizaram o acesso a essa poderosa ferramenta, permitindo que empresas de todos os portes realizem experimentos criteriosos. Com a Landingi, você pode criar uma ótima campanha e otimizá-la com testes multivariados, agendador de campanhas, substituição dinâmica de texto e opções de personalização para obter os melhores resultados. O mais interessante é que você pode começar a usar a plataforma Landingi gratuitamente!